:110 -The configuration file used is file:/root/seata-config/registry.conf

-2020-04-15 00:55:12.426 INFO [main]com.alibaba.druid.pool.DruidDataSource.init:947 -{dataSource-1} inited

-2020-04-15 00:55:13.127 INFO [main]io.seata.core.rpc.netty.RpcServerBootstrap.start:155 -Server started

-```

-

-其中`{dataSource-1} `说明使用了数据库,并正常初始化完成

-

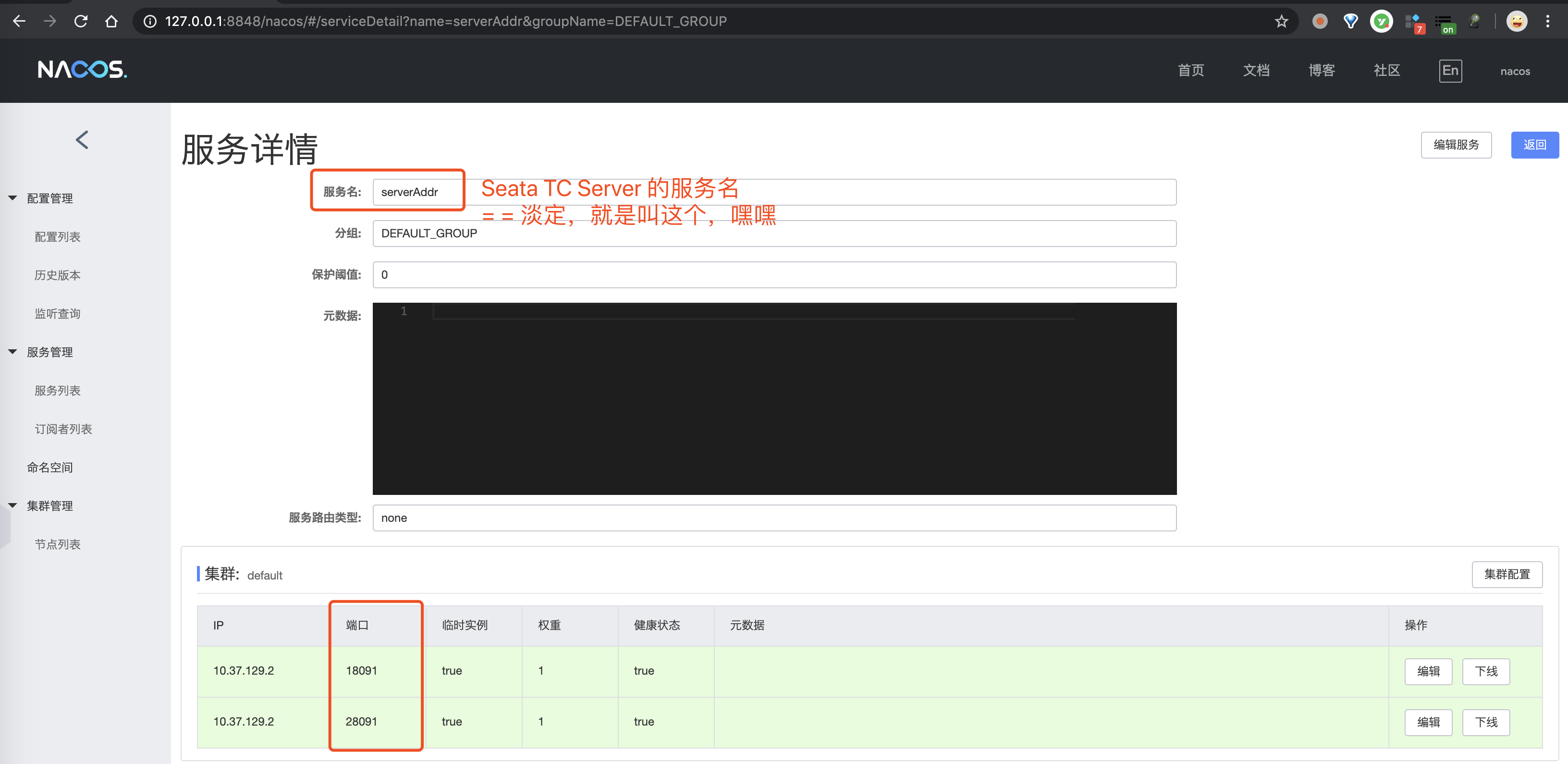

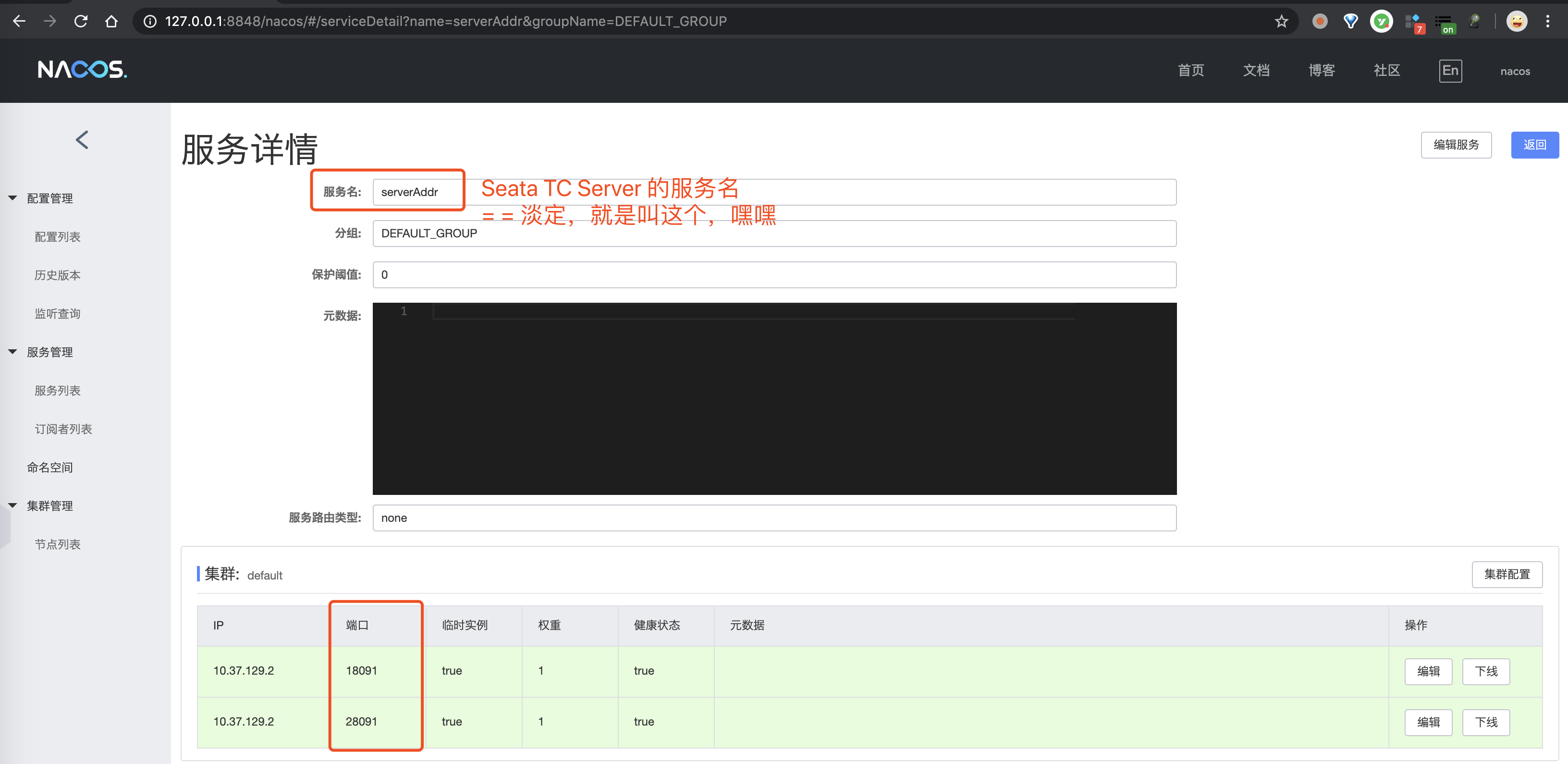

-- 查看注册中心,此时seata-serve 这个服务会有三个实例

-

-

-

-

-## 部署业务服务

-

-- 创建业务表并初始化数据

-

-具体的业务表可以参考 [cloud-seata-nacos/README.md](https://github.com/helloworlde/spring-cloud-alibaba-component/blob/master/cloud-seata-nacos/README.md)

-

-- 添加 Nacos 配置

-

-在 public 的命名空间下,分别创建 data-id 为 `order-service.properties`, `pay-service.properties`, `storage-service.properties` 的配置,内容相同,需要修改数据库的地址、用户名和密码

-

-```

-# MySQL

-spring.datasource.url=jdbc:mysql://192.168.199.2:30060/seata?useUnicode=true&characterEncoding=utf8&allowMultiQueries=true&useSSL=false

-spring.datasource.username=root

-spring.datasource.password=123456

-spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver

-# Seata

-spring.cloud.alibaba.seata.tx-service-group=my_test_tx_group

-```

-

-- 部署服务

-

-通过 application.yaml 配置文件部署服务,需要注意的是修改 ConfigMap 的 `NACOS_ADDR`为自己的 Nacos 地址

-

-```yaml

-apiVersion: v1

-kind: Service

-metadata:

- namespace: default

- name: seata-ha-service

- labels:

- app.kubernetes.io/name: seata-ha-service

-spec:

- type: NodePort

- ports:

- - port: 8081

- nodePort: 30081

- protocol: TCP

- name: http

- selector:

- app.kubernetes.io/name: seata-ha-service

-

----

-apiVersion: v1

-kind: ConfigMap

-metadata:

- name: seata-ha-service-config

-data:

- NACOS_ADDR: 192.168.199.2:8848

-

----

-apiVersion: v1

-kind: ServiceAccount

-metadata:

- name: seata-ha-account

- namespace: default

-

----

-apiVersion: rbac.authorization.k8s.io/v1beta1

-kind: ClusterRoleBinding

-metadata:

- name: seata-ha-account

-roleRef:

- apiGroup: rbac.authorization.k8s.io

- kind: ClusterRole

- name: cluster-admin

-subjects:

- - kind: ServiceAccount

- name: seata-ha-account

- namespace: default

-

----

-apiVersion: apps/v1

-kind: Deployment

-metadata:

- namespace: default

- name: seata-ha-service

- labels:

- app.kubernetes.io/name: seata-ha-service

-spec:

- replicas: 1

- selector:

- matchLabels:

- app.kubernetes.io/name: seata-ha-service

- template:

- metadata:

- labels:

- app.kubernetes.io/name: seata-ha-service

- spec:

- serviceAccountName: seata-ha-account

- containers:

- - name: seata-ha-order-service

- image: "registry.cn-qingdao.aliyuncs.com/hellowoodes/seata-ha-order-service:1.1"

- imagePullPolicy: IfNotPresent

- env:

- - name: NACOS_ADDR

- valueFrom:

- configMapKeyRef:

- key: NACOS_ADDR

- name: seata-ha-service-config

- ports:

- - name: http

- containerPort: 8081

- protocol: TCP

- - name: seata-ha-pay-service

- image: "registry.cn-qingdao.aliyuncs.com/hellowoodes/seata-ha-pay-service:1.1"

- imagePullPolicy: IfNotPresent

- env:

- - name: NACOS_ADDR

- valueFrom:

- configMapKeyRef:

- key: NACOS_ADDR

- name: seata-ha-service-config

- ports:

- - name: http

- containerPort: 8082

- protocol: TCP

- - name: seata-ha-storage-service

- image: "registry.cn-qingdao.aliyuncs.com/hellowoodes/seata-ha-storage-service:1.1"

- imagePullPolicy: IfNotPresent

- env:

- - name: NACOS_ADDR

- valueFrom:

- configMapKeyRef:

- key: NACOS_ADDR

- name: seata-ha-service-config

- ports:

- - name: http

- containerPort: 8083

- protocol: TCP

-```

-

-通过以下命令,将应用部署到集群中

-

-```bash

-kubectl apply -f application.yaml

-```

-

-然后查看创建的 pod,seata-ha-service 这个服务下有三个 pod

-

-```bash

-kubectl get pod | grep seata-ha-service

-

-seata-ha-service-7dbdc6894b-5r8q4 3/3 Running 0 12m

-```

-

-待应用启动后,在 Nacos 的服务列表中,会有相应的服务

-

-

-

-此时查看服务的日志,会看到服务向每一个 TC 都注册了

-

-```bash

-kubectl logs -f seata-ha-service-7dbdc6894b-5r8q4 seata-ha-order-service

-```

-

-

-

-查看任意的 TC 日志,会发现每一个服务都向 TC 注册了

-

-```bash

-kubelet logs -f seata-ha-server-645844b8b6-9qh5j

-```

-

-

-

-

-## 测试

-

-

-### 测试成功场景

-

-调用下单接口,将 price 设置为 1,因为初始化的余额为 10,可以下单成功

-

-```bash

-curl -X POST \

- http://192.168.199.2:30081/order/placeOrder \

- -H 'Content-Type: application/json' \

- -d '{

- "userId": 1,

- "productId": 1,

- "price": 1

-}'

-```

-

-此时返回结果为:

-

-```json

-{"success":true,"message":null,"data":null}

-```

-

-查看TC 的日志,事务成功提交:

-

-

-

-查看 order-service 服务日志

-

-

-

-### 测试失败场景

-

-设置 price 为 100,此时余额不足,会下单失败抛出异常,事务会回滚

-

-```bash

-curl -X POST \

- http://192.168.199.2:30081/order/placeOrder \

- -H 'Content-Type: application/json' \

- -d '{

- "userId": 1,

- "productId": 1,

- "price": 100

-}'

-```

-

-查看 TC 的日志:

-

-

-查看服务的日志 :

-

-

-多次调用查看服务日志,发现会随机的向其中某台TC发起事务注册,当扩容或缩容后,有相应的 TC 参与或退出,证明高可用部署生效

-

+Placeholder. DO NOT DELETE.

\ No newline at end of file

diff --git a/blog/seata-meetup-hangzhou.md b/blog/seata-meetup-hangzhou.md

index 5671ad3e96..e872b67af1 100644

--- a/blog/seata-meetup-hangzhou.md

+++ b/blog/seata-meetup-hangzhou.md

@@ -1,50 +1 @@

----

-title: Seata Community Meetup·杭州站

-keywords: [Seata, 杭州, meetup]

-description: Seata Community Meetup·杭州站,于12月21号在杭州市梦想小镇浙江青年众创空间完美举办

----

-

-# Seata Meetup·杭州站成功举办

-

-

-

-### 活动介绍

-

-### 亮点解读

-

-- Seata 开源项目发起人带来《Seata 过去、现在和未来》以及 Seata 1.0 的新特性。

-- Seata 核心贡献者详解 Seata AT, TCC, Saga 模式。

-- Seata 落地互联网医疗,滴滴出行实践剖析。

-

-- [回放福利(开发者社区)](https://developer.aliyun.com/live/1760)

-- [加入 Seata 千人钉钉群](http://w2wz.com/h2nb)

-

-### 分享嘉宾

-

-- 季敏(清铭) 《Seata 的过去、现在和未来》 [slides](https://github.com/a364176773/awesome-seata/blob/master/slides/meetup/201912%40hangzhou/%E5%AD%A3%E6%95%8F%EF%BC%88%E6%B8%85%E9%93%AD%EF%BC%89%E3%80%8ASeata%20%E7%9A%84%E8%BF%87%E5%8E%BB%E3%80%81%E7%8E%B0%E5%9C%A8%E5%92%8C%E6%9C%AA%E6%9D%A5%E3%80%8B.pdf)

-

-

-

-- 吴江坷《我与SEATA的开源之路以及SEATA在互联网医疗系统中的应用》 [slides](https://github.com/seata/awesome-seata/blob/master/slides/meetup/201912%40hangzhou/%E5%AD%A3%E6%95%8F%EF%BC%88%E6%B8%85%E9%93%AD%EF%BC%89%E3%80%8ASeata%20%E7%9A%84%E8%BF%87%E5%8E%BB%E3%80%81%E7%8E%B0%E5%9C%A8%E5%92%8C%E6%9C%AA%E6%9D%A5%E3%80%8B.pdf)

-

-

-

-- 申海强(煊檍)《带你读透 Seata AT 模式的精髓》 [slides](https://github.com/seata/awesome-seata/tree/master/slides/meetup/201912%40hangzhou)

-

-

-

-- 张森 《分布式事务Seata之TCC模式详解》

-

-

-

-- 陈龙(屹远)《Seata 长事务解决方案 Saga 模式》

-

-

-

-- 陈鹏志《Seata%20在滴滴两轮车业务的实践》 [slides](https://github.com/seata/awesome-seata/blob/master/slides/meetup/201912%40hangzhou/%E9%99%88%E9%B9%8F%E5%BF%97%E3%80%8ASeata%20%E5%9C%A8%E6%BB%B4%E6%BB%B4%E4%B8%A4%E8%BD%AE%E8%BD%A6%E4%B8%9A%E5%8A%A1%E7%9A%84%E5%AE%9E%E8%B7%B5%E3%80%8B.pdf)

-

-

-

-### 特别嘉奖

-

-

\ No newline at end of file

+Placeholder. DO NOT DELETE.

\ No newline at end of file

diff --git a/blog/seata-mybatisplus-analysis.md b/blog/seata-mybatisplus-analysis.md

index f85bd6fa90..e872b67af1 100644

--- a/blog/seata-mybatisplus-analysis.md

+++ b/blog/seata-mybatisplus-analysis.md

@@ -1,540 +1 @@

----

-title: 透过源码解决SeataAT模式整合Mybatis-Plus失去MP特性的问题

-keywords: [Seata,Mybatis-Plus,分布式事务]

-description: 本文讲述如何透过源码解决Seata整合Mybatis-Plus失去MP特性的问题

-author: FUNKYE

-date: 2019/11/30

-

----

-

-# 透过源码解决SeataAT模式整合Mybatis-Plus失去MP特性的问题

-

-项目地址:https://gitee.com/itCjb/springboot-dubbo-mybatisplus-seata

-

-本文作者:FUNKYE(陈健斌),杭州某互联网公司主程。

-

-# 介绍

-

-Mybatis-Plus:[MyBatis-Plus](https://github.com/baomidou/mybatis-plus)(简称 MP)是一个 [MyBatis](http://www.mybatis.org/mybatis-3/) 的增强工具,在 MyBatis 的基础上只做增强不做改变,为简化开发、提高效率而生。

-

-MP配置:

-

-```xml

-

-

-

-```

-

-Seata:Seata 是一款开源的分布式事务解决方案,致力于提供高性能和简单易用的分布式事务服务。Seata 将为用户提供了 AT、TCC、SAGA 和 XA 事务模式,为用户打造一站式的分布式解决方案。

-

-AT模式机制:

-

-- 一阶段:业务数据和回滚日志记录在同一个本地事务中提交,释放本地锁和连接资源。

-- 二阶段:

- - 提交异步化,非常快速地完成。

- - 回滚通过一阶段的回滚日志进行反向补偿。

-

-## 分析原因

-

- 1.首先我们通过介绍,可以看到,mp是需要注册sqlSessionFactory,注入数据源,而Seata是通过代理数据源来保证事务的正常回滚跟提交。

-

- 2.我们来看基于seata的官方demo提供的SeataAutoConfig的代码

-

-```java

-package org.test.config;

-

-import javax.sql.DataSource;

-

-import org.apache.ibatis.session.SqlSessionFactory;

-import org.slf4j.Logger;

-import org.slf4j.LoggerFactory;

-import org.springframework.beans.factory.annotation.Autowired;

-import org.springframework.boot.autoconfigure.jdbc.DataSourceProperties;

-import org.springframework.context.annotation.Bean;

-import org.springframework.context.annotation.Configuration;

-import org.springframework.context.annotation.Primary;

-

-import com.alibaba.druid.pool.DruidDataSource;

-import com.baomidou.mybatisplus.extension.spring.MybatisSqlSessionFactoryBean;

-

-import io.seata.rm.datasource.DataSourceProxy;

-import io.seata.spring.annotation.GlobalTransactionScanner;

-

-@Configuration

-public class SeataAutoConfig {

- @Autowired(required = true)

- private DataSourceProperties dataSourceProperties;

- private final static Logger logger = LoggerFactory.getLogger(SeataAutoConfig.class);

-

- @Bean(name = "dataSource") // 声明其为Bean实例

- @Primary // 在同样的DataSource中,首先使用被标注的DataSource

- public DataSource druidDataSource() {

- DruidDataSource druidDataSource = new DruidDataSource();

- logger.info("dataSourceProperties.getUrl():{}",dataSourceProperties.getUrl());

- druidDataSource.setUrl(dataSourceProperties.getUrl());

- druidDataSource.setUsername(dataSourceProperties.getUsername());

- druidDataSource.setPassword(dataSourceProperties.getPassword());

- druidDataSource.setDriverClassName(dataSourceProperties.getDriverClassName());

- druidDataSource.setInitialSize(0);

- druidDataSource.setMaxActive(180);

- druidDataSource.setMaxWait(60000);

- druidDataSource.setMinIdle(0);

- druidDataSource.setValidationQuery("Select 1 from DUAL");

- druidDataSource.setTestOnBorrow(false);

- druidDataSource.setTestOnReturn(false);

- druidDataSource.setTestWhileIdle(true);

- druidDataSource.setTimeBetweenEvictionRunsMillis(60000);

- druidDataSource.setMinEvictableIdleTimeMillis(25200000);

- druidDataSource.setRemoveAbandoned(true);

- druidDataSource.setRemoveAbandonedTimeout(1800);

- druidDataSource.setLogAbandoned(true);

- logger.info("装载dataSource........");

- return druidDataSource;

- }

-

- /**

- * init datasource proxy

- *

- * @Param: druidDataSource datasource bean instance

- * @Return: DataSourceProxy datasource proxy

- */

- @Bean

- public DataSourceProxy dataSourceProxy(DataSource dataSource) {

- logger.info("代理dataSource........");

- return new DataSourceProxy(dataSource);

- }

-

- @Bean

- public SqlSessionFactory sqlSessionFactory(DataSourceProxy dataSourceProxy) throws Exception {

- MybatisSqlSessionFactoryBean factory = new MybatisSqlSessionFactoryBean();

- factory.setDataSource(dataSourceProxy);

- factory.setMapperLocations(new PathMatchingResourcePatternResolver()

- .getResources("classpath*:/mapper/*.xml"));

- return factory.getObject();

- }

-

- /**

- * init global transaction scanner

- *

- * @Return: GlobalTransactionScanner

- */

- @Bean

- public GlobalTransactionScanner globalTransactionScanner() {

- logger.info("配置seata........");

- return new GlobalTransactionScanner("test-service", "test-group");

- }

-}

-

-```

-

-首先看到我们的seata配置数据源的类里,我们配置了一个数据源,然后又配置了一个seata代理datasource的bean,这时候.

-

-然后我们如果直接启动mp整合seata的项目会发现,分页之类的插件会直接失效,连扫描mapper都得从代码上写,这是为什么呢?

-

-通过阅读以上代码,是因为我们另外的配置了一个sqlSessionFactory,导致mp的sqlSessionFactory失效了,这时候我们发现了问题的所在了,即使我们不配置sqlSessionFactoryl,也会因为mp所使用的数据源不是被seata代理过后的数据源,导致分布式事务失效.但是如何解决这个问题呢?

-

-这时候我们需要去阅读mp的源码,找到他的启动类,一看便知

-

-```java

-/*

- * Copyright (c) 2011-2020, baomidou (jobob@qq.com).

- *

- * Licensed under the Apache License, Version 2.0 (the "License"); you may not

- * use this file except in compliance with the License. You may obtain a copy of

- * the License at

- *

- * https://www.apache.org/licenses/LICENSE-2.0

- *

- * Unless required by applicable law or agreed to in writing, software

- * distributed under the License is distributed on an "AS IS" BASIS, WITHOUT

- * WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the

- * License for the specific language governing permissions and limitations under

- * the License.

- */

-package com.baomidou.mybatisplus.autoconfigure;

-

-

-import com.baomidou.mybatisplus.core.MybatisConfiguration;

-import com.baomidou.mybatisplus.core.config.GlobalConfig;

-import com.baomidou.mybatisplus.core.handlers.MetaObjectHandler;

-import com.baomidou.mybatisplus.core.incrementer.IKeyGenerator;

-import com.baomidou.mybatisplus.core.injector.ISqlInjector;

-import com.baomidou.mybatisplus.extension.spring.MybatisSqlSessionFactoryBean;

-import org.apache.ibatis.annotations.Mapper;

-import org.apache.ibatis.mapping.DatabaseIdProvider;

-import org.apache.ibatis.plugin.Interceptor;

-import org.apache.ibatis.scripting.LanguageDriver;

-import org.apache.ibatis.session.ExecutorType;

-import org.apache.ibatis.session.SqlSessionFactory;

-import org.apache.ibatis.type.TypeHandler;

-import org.mybatis.spring.SqlSessionFactoryBean;

-import org.mybatis.spring.SqlSessionTemplate;

-import org.mybatis.spring.mapper.MapperFactoryBean;

-import org.mybatis.spring.mapper.MapperScannerConfigurer;

-import org.slf4j.Logger;

-import org.slf4j.LoggerFactory;

-import org.springframework.beans.BeanWrapper;

-import org.springframework.beans.BeanWrapperImpl;

-import org.springframework.beans.factory.BeanFactory;

-import org.springframework.beans.factory.BeanFactoryAware;

-import org.springframework.beans.factory.InitializingBean;

-import org.springframework.beans.factory.ObjectProvider;

-import org.springframework.beans.factory.support.BeanDefinitionBuilder;

-import org.springframework.beans.factory.support.BeanDefinitionRegistry;

-import org.springframework.boot.autoconfigure.AutoConfigurationPackages;

-import org.springframework.boot.autoconfigure.AutoConfigureAfter;

-import org.springframework.boot.autoconfigure.EnableAutoConfiguration;

-import org.springframework.boot.autoconfigure.condition.ConditionalOnClass;

-import org.springframework.boot.autoconfigure.condition.ConditionalOnMissingBean;

-import org.springframework.boot.autoconfigure.condition.ConditionalOnSingleCandidate;

-import org.springframework.boot.autoconfigure.jdbc.DataSourceAutoConfiguration;

-import org.springframework.boot.context.properties.EnableConfigurationProperties;

-import org.springframework.context.ApplicationContext;

-import org.springframework.context.annotation.Bean;

-import org.springframework.context.annotation.Configuration;

-import org.springframework.context.annotation.Import;

-import org.springframework.context.annotation.ImportBeanDefinitionRegistrar;

-import org.springframework.core.io.Resource;

-import org.springframework.core.io.ResourceLoader;

-import org.springframework.core.type.AnnotationMetadata;

-import org.springframework.util.Assert;

-import org.springframework.util.CollectionUtils;

-import org.springframework.util.ObjectUtils;

-import org.springframework.util.StringUtils;

-

-import javax.sql.DataSource;

-import java.util.List;

-import java.util.Optional;

-import java.util.stream.Stream;

-

-/**

- * {@link EnableAutoConfiguration Auto-Configuration} for Mybatis. Contributes a

- * {@link SqlSessionFactory} and a {@link SqlSessionTemplate}.

- *

- * If {@link org.mybatis.spring.annotation.MapperScan} is used, or a

- * configuration file is specified as a property, those will be considered,

- * otherwise this auto-configuration will attempt to register mappers based on

- * the interface definitions in or under the root auto-configuration package.

- *

- * copy from {@link org.mybatis.spring.boot.autoconfigure.MybatisAutoConfiguration}

- *

- * @author Eddú Meléndez

- * @author Josh Long

- * @author Kazuki Shimizu

- * @author Eduardo Macarrón

- */

-@Configuration

-@ConditionalOnClass({SqlSessionFactory.class, SqlSessionFactoryBean.class})

-@ConditionalOnSingleCandidate(DataSource.class)

-@EnableConfigurationProperties(MybatisPlusProperties.class)

-@AutoConfigureAfter(DataSourceAutoConfiguration.class)

-public class MybatisPlusAutoConfiguration implements InitializingBean {

-

- private static final Logger logger = LoggerFactory.getLogger(MybatisPlusAutoConfiguration.class);

-

- private final MybatisPlusProperties properties;

-

- private final Interceptor[] interceptors;

-

- private final TypeHandler[] typeHandlers;

-

- private final LanguageDriver[] languageDrivers;

-

- private final ResourceLoader resourceLoader;

-

- private final DatabaseIdProvider databaseIdProvider;

-

- private final List configurationCustomizers;

-

- private final List mybatisPlusPropertiesCustomizers;

-

- private final ApplicationContext applicationContext;

-

-

- public MybatisPlusAutoConfiguration(MybatisPlusProperties properties,

- ObjectProvider interceptorsProvider,

- ObjectProvider typeHandlersProvider,

- ObjectProvider languageDriversProvider,

- ResourceLoader resourceLoader,

- ObjectProvider databaseIdProvider,

- ObjectProvider> configurationCustomizersProvider,

- ObjectProvider> mybatisPlusPropertiesCustomizerProvider,

- ApplicationContext applicationContext) {

- this.properties = properties;

- this.interceptors = interceptorsProvider.getIfAvailable();

- this.typeHandlers = typeHandlersProvider.getIfAvailable();

- this.languageDrivers = languageDriversProvider.getIfAvailable();

- this.resourceLoader = resourceLoader;

- this.databaseIdProvider = databaseIdProvider.getIfAvailable();

- this.configurationCustomizers = configurationCustomizersProvider.getIfAvailable();

- this.mybatisPlusPropertiesCustomizers = mybatisPlusPropertiesCustomizerProvider.getIfAvailable();

- this.applicationContext = applicationContext;

- }

-

- @Override

- public void afterPropertiesSet() {

- if (!CollectionUtils.isEmpty(mybatisPlusPropertiesCustomizers)) {

- mybatisPlusPropertiesCustomizers.forEach(i -> i.customize(properties));

- }

- checkConfigFileExists();

- }

-

- private void checkConfigFileExists() {

- if (this.properties.isCheckConfigLocation() && StringUtils.hasText(this.properties.getConfigLocation())) {

- Resource resource = this.resourceLoader.getResource(this.properties.getConfigLocation());

- Assert.state(resource.exists(),

- "Cannot find config location: " + resource + " (please add config file or check your Mybatis configuration)");

- }

- }

-

- @SuppressWarnings("SpringJavaInjectionPointsAutowiringInspection")

- @Bean

- @ConditionalOnMissingBean

- public SqlSessionFactory sqlSessionFactory(DataSource dataSource) throws Exception {

- // TODO 使用 MybatisSqlSessionFactoryBean 而不是 SqlSessionFactoryBean

- MybatisSqlSessionFactoryBean factory = new MybatisSqlSessionFactoryBean();

- factory.setDataSource(dataSource);

- factory.setVfs(SpringBootVFS.class);

- if (StringUtils.hasText(this.properties.getConfigLocation())) {

- factory.setConfigLocation(this.resourceLoader.getResource(this.properties.getConfigLocation()));

- }

- applyConfiguration(factory);

- if (this.properties.getConfigurationProperties() != null) {

- factory.setConfigurationProperties(this.properties.getConfigurationProperties());

- }

- if (!ObjectUtils.isEmpty(this.interceptors)) {

- factory.setPlugins(this.interceptors);

- }

- if (this.databaseIdProvider != null) {

- factory.setDatabaseIdProvider(this.databaseIdProvider);

- }

- if (StringUtils.hasLength(this.properties.getTypeAliasesPackage())) {

- factory.setTypeAliasesPackage(this.properties.getTypeAliasesPackage());

- }

- if (this.properties.getTypeAliasesSuperType() != null) {

- factory.setTypeAliasesSuperType(this.properties.getTypeAliasesSuperType());

- }

- if (StringUtils.hasLength(this.properties.getTypeHandlersPackage())) {

- factory.setTypeHandlersPackage(this.properties.getTypeHandlersPackage());

- }

- if (!ObjectUtils.isEmpty(this.typeHandlers)) {

- factory.setTypeHandlers(this.typeHandlers);

- }

- if (!ObjectUtils.isEmpty(this.properties.resolveMapperLocations())) {

- factory.setMapperLocations(this.properties.resolveMapperLocations());

- }

-

- // TODO 对源码做了一定的修改(因为源码适配了老旧的mybatis版本,但我们不需要适配)

- Class defaultLanguageDriver = this.properties.getDefaultScriptingLanguageDriver();

- if (!ObjectUtils.isEmpty(this.languageDrivers)) {

- factory.setScriptingLanguageDrivers(this.languageDrivers);

- }

- Optional.ofNullable(defaultLanguageDriver).ifPresent(factory::setDefaultScriptingLanguageDriver);

-

- // TODO 自定义枚举包

- if (StringUtils.hasLength(this.properties.getTypeEnumsPackage())) {

- factory.setTypeEnumsPackage(this.properties.getTypeEnumsPackage());

- }

- // TODO 此处必为非 NULL

- GlobalConfig globalConfig = this.properties.getGlobalConfig();

- // TODO 注入填充器

- if (this.applicationContext.getBeanNamesForType(MetaObjectHandler.class,

- false, false).length > 0) {

- MetaObjectHandler metaObjectHandler = this.applicationContext.getBean(MetaObjectHandler.class);

- globalConfig.setMetaObjectHandler(metaObjectHandler);

- }

- // TODO 注入主键生成器

- if (this.applicationContext.getBeanNamesForType(IKeyGenerator.class, false,

- false).length > 0) {

- IKeyGenerator keyGenerator = this.applicationContext.getBean(IKeyGenerator.class);

- globalConfig.getDbConfig().setKeyGenerator(keyGenerator);

- }

- // TODO 注入sql注入器

- if (this.applicationContext.getBeanNamesForType(ISqlInjector.class, false,

- false).length > 0) {

- ISqlInjector iSqlInjector = this.applicationContext.getBean(ISqlInjector.class);

- globalConfig.setSqlInjector(iSqlInjector);

- }

- // TODO 设置 GlobalConfig 到 MybatisSqlSessionFactoryBean

- factory.setGlobalConfig(globalConfig);

- return factory.getObject();

- }

-

- // TODO 入参使用 MybatisSqlSessionFactoryBean

- private void applyConfiguration(MybatisSqlSessionFactoryBean factory) {

- // TODO 使用 MybatisConfiguration

- MybatisConfiguration configuration = this.properties.getConfiguration();

- if (configuration == null && !StringUtils.hasText(this.properties.getConfigLocation())) {

- configuration = new MybatisConfiguration();

- }

- if (configuration != null && !CollectionUtils.isEmpty(this.configurationCustomizers)) {

- for (ConfigurationCustomizer customizer : this.configurationCustomizers) {

- customizer.customize(configuration);

- }

- }

- factory.setConfiguration(configuration);

- }

-

- @Bean

- @ConditionalOnMissingBean

- public SqlSessionTemplate sqlSessionTemplate(SqlSessionFactory sqlSessionFactory) {

- ExecutorType executorType = this.properties.getExecutorType();

- if (executorType != null) {

- return new SqlSessionTemplate(sqlSessionFactory, executorType);

- } else {

- return new SqlSessionTemplate(sqlSessionFactory);

- }

- }

-

- /**

- * This will just scan the same base package as Spring Boot does. If you want more power, you can explicitly use

- * {@link org.mybatis.spring.annotation.MapperScan} but this will get typed mappers working correctly, out-of-the-box,

- * similar to using Spring Data JPA repositories.

- */

- public static class AutoConfiguredMapperScannerRegistrar implements BeanFactoryAware, ImportBeanDefinitionRegistrar {

-

- private BeanFactory beanFactory;

-

- @Override

- public void registerBeanDefinitions(AnnotationMetadata importingClassMetadata, BeanDefinitionRegistry registry) {

-

- if (!AutoConfigurationPackages.has(this.beanFactory)) {

- logger.debug("Could not determine auto-configuration package, automatic mapper scanning disabled.");

- return;

- }

-

- logger.debug("Searching for mappers annotated with @Mapper");

-

- List packages = AutoConfigurationPackages.get(this.beanFactory);

- if (logger.isDebugEnabled()) {

- packages.forEach(pkg -> logger.debug("Using auto-configuration base package '{}'", pkg));

- }

-

- BeanDefinitionBuilder builder = BeanDefinitionBuilder.genericBeanDefinition(MapperScannerConfigurer.class);

- builder.addPropertyValue("processPropertyPlaceHolders", true);

- builder.addPropertyValue("annotationClass", Mapper.class);

- builder.addPropertyValue("basePackage", StringUtils.collectionToCommaDelimitedString(packages));

- BeanWrapper beanWrapper = new BeanWrapperImpl(MapperScannerConfigurer.class);

- Stream.of(beanWrapper.getPropertyDescriptors())

- // Need to mybatis-spring 2.0.2+

- .filter(x -> x.getName().equals("lazyInitialization")).findAny()

- .ifPresent(x -> builder.addPropertyValue("lazyInitialization", "${mybatis.lazy-initialization:false}"));

- registry.registerBeanDefinition(MapperScannerConfigurer.class.getName(), builder.getBeanDefinition());

- }

-

- @Override

- public void setBeanFactory(BeanFactory beanFactory) {

- this.beanFactory = beanFactory;

- }

- }

-

- /**

- * If mapper registering configuration or mapper scanning configuration not present, this configuration allow to scan

- * mappers based on the same component-scanning path as Spring Boot itself.

- */

- @Configuration

- @Import(AutoConfiguredMapperScannerRegistrar.class)

- @ConditionalOnMissingBean({MapperFactoryBean.class, MapperScannerConfigurer.class})

- public static class MapperScannerRegistrarNotFoundConfiguration implements InitializingBean {

-

- @Override

- public void afterPropertiesSet() {

- logger.debug(

- "Not found configuration for registering mapper bean using @MapperScan, MapperFactoryBean and MapperScannerConfigurer.");

- }

- }

-}

-

-```

-

-看到mp启动类里的sqlSessionFactory方法了吗,他也是一样的注入一个数据源,这时候大家应该都知道解决方法了吧?

-

-没错,就是把被代理过的数据源给放到mp的sqlSessionFactory中.

-

-很简单,我们需要稍微改动一下我们的seata配置类就行了

-

-```java

-package org.test.config;

-

-import javax.sql.DataSource;

-

-import org.mybatis.spring.annotation.MapperScan;

-import org.slf4j.Logger;

-import org.slf4j.LoggerFactory;

-import org.springframework.beans.factory.annotation.Autowired;

-import org.springframework.boot.autoconfigure.jdbc.DataSourceProperties;

-import org.springframework.context.annotation.Bean;

-import org.springframework.context.annotation.Configuration;

-import org.springframework.context.annotation.Primary;

-

-import com.alibaba.druid.pool.DruidDataSource;

-

-import io.seata.rm.datasource.DataSourceProxy;

-import io.seata.spring.annotation.GlobalTransactionScanner;

-

-@Configuration

-@MapperScan("com.baomidou.springboot.mapper*")

-public class SeataAutoConfig {

- @Autowired(required = true)

- private DataSourceProperties dataSourceProperties;

- private final static Logger logger = LoggerFactory.getLogger(SeataAutoConfig.class);

- private DataSourceProxy dataSourceProxy;

-

- @Bean(name = "dataSource") // 声明其为Bean实例

- @Primary // 在同样的DataSource中,首先使用被标注的DataSource

- public DataSource druidDataSource() {

- DruidDataSource druidDataSource = new DruidDataSource();

- logger.info("dataSourceProperties.getUrl():{}", dataSourceProperties.getUrl());

- druidDataSource.setUrl(dataSourceProperties.getUrl());

- druidDataSource.setUsername(dataSourceProperties.getUsername());

- druidDataSource.setPassword(dataSourceProperties.getPassword());

- druidDataSource.setDriverClassName(dataSourceProperties.getDriverClassName());

- druidDataSource.setInitialSize(0);

- druidDataSource.setMaxActive(180);

- druidDataSource.setMaxWait(60000);

- druidDataSource.setMinIdle(0);

- druidDataSource.setValidationQuery("Select 1 from DUAL");

- druidDataSource.setTestOnBorrow(false);

- druidDataSource.setTestOnReturn(false);

- druidDataSource.setTestWhileIdle(true);

- druidDataSource.setTimeBetweenEvictionRunsMillis(60000);

- druidDataSource.setMinEvictableIdleTimeMillis(25200000);

- druidDataSource.setRemoveAbandoned(true);

- druidDataSource.setRemoveAbandonedTimeout(1800);

- druidDataSource.setLogAbandoned(true);

- logger.info("装载dataSource........");

- dataSourceProxy = new DataSourceProxy(druidDataSource);

- return dataSourceProxy;

- }

-

- /**

- * init datasource proxy

- *

- * @Param: druidDataSource datasource bean instance

- * @Return: DataSourceProxy datasource proxy

- */

- @Bean

- public DataSourceProxy dataSourceProxy() {

- logger.info("代理dataSource........");

- return dataSourceProxy;

- }

-

- /**

- * init global transaction scanner

- *

- * @Return: GlobalTransactionScanner

- */

- @Bean

- public GlobalTransactionScanner globalTransactionScanner() {

- logger.info("配置seata........");

- return new GlobalTransactionScanner("test-service", "test-group");

- }

-}

-

-```

-

-看代码,我们去掉了自己配置的sqlSessionFactory,直接让DataSource bean返回的是一个被代理过的bean,并且我们加入了@Primary,导致mp优先使用我们配置的数据源,这样就解决了mp因为seata代理了数据源跟创建了新的sqlSessionFactory,导致mp的插件,组件失效的bug了!

-

-# 总结

-

-踩到坑不可怕,主要又耐心的顺着每个组件实现的原理,再去思考,查找对应冲突的代码块,你一定能找到个兼容二者的方法。

+Placeholder. DO NOT DELETE.

\ No newline at end of file

diff --git a/blog/seata-nacos-analysis.md b/blog/seata-nacos-analysis.md

index 4654b50ba0..e872b67af1 100644

--- a/blog/seata-nacos-analysis.md

+++ b/blog/seata-nacos-analysis.md

@@ -1,435 +1 @@

----

-title: Seata分布式事务启用Nacos做配置中心

-keywords: [Seata,Nacos,分布式事务]

-description: 本文讲述如何使用Seata整合Nacos配置

-author: FUNKYE

-date: 2019/12/02

----

-

-# Seata分布式事务启用Nacos做配置中心

-

-[项目地址](https://gitee.com/itCjb/springboot-dubbo-mybatisplus-seata )

-

-本文作者:FUNKYE(陈健斌),杭州某互联网公司主程。

-

-# 前言

-

-上次发布了直连方式的seata配置,详细可以看这篇[博客](http://seata.io/zh-cn/blog/springboot-dubbo-mybatisplus-seata.html)

-

-我们接着上一篇的基础上去配置nacos做配置中心跟dubbo注册中心.

-

-## 准备工作

-

- 1.首先去nacos的github上下载[最新版本](https://github.com/alibaba/nacos/releases/tag/1.1.4)

-

-

-

- 2.下载好了后,很简单,解压后到bin目录下去启动就好了,看到如图所示就成了:

-

-

-

- 3.启动完毕后访问:http://127.0.0.1:8848/nacos/#/login

-

-

-

-是不是看到这样的界面了?输入nacos(账号密码相同),先进去看看吧.

-

-这时候可以发现没有任何服务注册

-

-

-

-别急我们马上让seata服务连接进来.

-

-## Seata配置

-

- 1.进入seata的conf文件夹看到这个木有?

-

-

-

-就是它,编辑它:

-

-

-

-

-

- 2.然后记得保存哦!接着我们把registry.conf文件打开编辑:

-

-```

-registry {

- # file 、nacos 、eureka、redis、zk、consul、etcd3、sofa

- type = "nacos"

-

- nacos {

- serverAddr = "localhost"

- namespace = ""

- cluster = "default"

- }

- eureka {

- serviceUrl = "http://localhost:8761/eureka"

- application = "default"

- weight = "1"

- }

- redis {

- serverAddr = "localhost:6379"

- db = "0"

- }

- zk {

- cluster = "default"

- serverAddr = "127.0.0.1:2181"

- session.timeout = 6000

- connect.timeout = 2000

- }

- consul {

- cluster = "default"

- serverAddr = "127.0.0.1:8500"

- }

- etcd3 {

- cluster = "default"

- serverAddr = "http://localhost:2379"

- }

- sofa {

- serverAddr = "127.0.0.1:9603"

- application = "default"

- region = "DEFAULT_ZONE"

- datacenter = "DefaultDataCenter"

- cluster = "default"

- group = "SEATA_GROUP"

- addressWaitTime = "3000"

- }

- file {

- name = "file.conf"

- }

-}

-

-config {

- # file、nacos 、apollo、zk、consul、etcd3

- type = "nacos"

-

- nacos {

- serverAddr = "localhost"

- namespace = ""

- }

- consul {

- serverAddr = "127.0.0.1:8500"

- }

- apollo {

- app.id = "seata-server"

- apollo.meta = "http://192.168.1.204:8801"

- }

- zk {

- serverAddr = "127.0.0.1:2181"

- session.timeout = 6000

- connect.timeout = 2000

- }

- etcd3 {

- serverAddr = "http://localhost:2379"

- }

- file {

- name = "file.conf"

- }

-}

-

-```

-

-都编辑好了后,我们运行nacos-config.sh,这时候我们配置的nacos-config.txt的内容已经被发送到nacos中了详细如图:

-

-

-

-出现以上类似的代码就是说明成功了,接着我们登录nacos配置中心,查看配置列表,出现如图列表说明配置成功了:

-

-

-

-看到了吧,你的配置已经全部都提交上去了,如果再git工具内运行sh不行的话,试着把编辑sh文件,试试改成如下操作

-

-```shell

-for line in $(cat nacos-config.txt)

-

-do

-

-key=${line%%=*}

-value=${line#*=}

-echo "\r\n set "${key}" = "${value}

-

-result=`curl -X POST "http://127.0.0.1:8848/nacos/v1/cs/configs?dataId=$key&group=SEATA_GROUP&content=$value"`

-

-if [ "$result"x == "true"x ]; then

-

- echo "\033[42;37m $result \033[0m"

-

-else

-

- echo "\033[41;37 $result \033[0m"

- let error++

-

-fi

-

-done

-

-

-if [ $error -eq 0 ]; then

-

-echo "\r\n\033[42;37m init nacos config finished, please start seata-server. \033[0m"

-

-else

-

-echo "\r\n\033[41;33m init nacos config fail. \033[0m"

-

-fi

-```

-

- 3.目前我们的准备工作全部完成,我们去seata-service/bin去运行seata服务吧,如图所示就成功啦!

-

-

-

-# 进行调试

-

- 1.首先把springboot-dubbo-mybatsiplus-seata项目的pom的依赖更改,去除掉zk这些配置,因为我们使用nacos做注册中心了.

-

-```java

-

- 3.1

- UTF-8

- UTF-8

- 1.8

- 1.8

- 3.2.0

- 3.2.0

-

-

- org.springframework.boot

- spring-boot-starter-parent

- 2.1.8.RELEASE

-

-

-

- com.alibaba.nacos

- nacos-client

- 1.1.4

-

-

- org.apache.dubbo

- dubbo-registry-nacos

- 2.7.4.1

-

-

- org.apache.dubbo

- dubbo-spring-boot-starter

- 2.7.4.1

-

-

- org.apache.commons

- commons-lang3

-

-

- com.alibaba

- fastjson

- 1.2.60

-

-

-

- io.springfox

- springfox-swagger2

- 2.9.2

-

-

- io.springfox

- springfox-swagger-ui

- 2.9.2

-

-

-

-

- com.baomidou

- mybatis-plus-boot-starter

- ${mybatis-plus-boot-starter.version}

-

-

-

-

- org.projectlombok

- lombok

- provided

-

-

- io.seata

- seata-all

- 0.9.0.1

-

-

-

-

-

-

- org.freemarker

- freemarker

-

-

-

- com.alibaba

- druid-spring-boot-starter

- 1.1.20

-

-

-

- com.fasterxml.jackson.dataformat

- jackson-dataformat-yaml

-

-

- org.springframework.boot

- spring-boot-starter-log4j2

-

-

-

- mysql

- mysql-connector-java

-

-

- org.springframework.boot

- spring-boot-starter-web

-

-

- org.springframework.boot

- spring-boot-starter-logging

-

-

- org.slf4j

- slf4j-log4j12

-

-

-

-

- org.springframework.boot

- spring-boot-starter-aop

-

-

- org.springframework.boot

- spring-boot-starter-test

- test

-

-

-

- org.springframework.boot

- spring-boot-configuration-processor

- true

-

-

-

-```

-

- 2.然后更改test-service的目录结构,删除zk的配置并更改application.yml文件,目录结构与代码:

-

-```yaml

-server:

- port: 38888

-spring:

- application:

- name: test-service

- datasource:

- type: com.alibaba.druid.pool.DruidDataSource

- url: jdbc:mysql://127.0.0.1:3306/test?useUnicode=true&characterEncoding=UTF-8&serverTimezone=UTC

- driver-class-name: com.mysql.cj.jdbc.Driver

- username: root

- password: 123456

-dubbo:

- protocol:

- loadbalance: leastactive

- threadpool: cached

- scan:

- base-packages: org。test.service

- application:

- qos-enable: false

- name: testserver

- registry:

- id: my-registry

- address: nacos://127.0.0.1:8848

-mybatis-plus:

- mapper-locations: classpath:/mapper/*Mapper.xml

- typeAliasesPackage: org.test.entity

- global-config:

- db-config:

- field-strategy: not-empty

- id-type: auto

- db-type: mysql

- configuration:

- map-underscore-to-camel-case: true

- cache-enabled: true

- auto-mapping-unknown-column-behavior: none

-```

-

- -

- 3.再更改registry.conf文件,如果你的nacos是其它服务器,请改成对应都ip跟端口

-

-```java

-registry {

- type = "nacos"

- file {

- name = "file.conf"

- }

- zk {

- cluster = "default"

- serverAddr = "127.0.0.1:2181"

- session.timeout = 6000

- connect.timeout = 2000

- }

- nacos {

- serverAddr = "localhost"

- namespace = ""

- cluster = "default"

- }

-}

-config {

- type = "nacos"

- file {

- name = "file.conf"

- }

- zk {

- serverAddr = "127.0.0.1:2181"

- session.timeout = 6000

- connect.timeout = 2000

- }

- nacos {

- serverAddr = "localhost"

- namespace = ""

- cluster = "default"

- }

-}

-```

-

- 4.接着我们运行provideApplication

-

-

-

-启动成功啦,我们再去看seata的日志:

-

-

-

-成功了,这下我们一样,去修改test-client的内容,首先一样application.yml,把zk换成nacos,这里就不详细描述了,把test-service内的registry.conf,复制到client项目的resources中覆盖原来的registry.conf.

-

-然后我们可以运行clientApplication:

-

-

-

- 5.确认服务已经被发布并测试事务运行是否正常

-

-

-

-服务成功发布出来,也被成功消费了.这下我们再去swagger中去测试回滚是否一切正常,访问http://127.0.0.1:28888/swagger-ui.html

-

-

-

-恭喜你,看到这一定跟我一样成功了!

-

-# 总结

-

-关于nacos的使用跟seata的简单搭建已经完成了,更详细的内容希望希望大家访问以下地址阅读详细文档

-

-[nacos官网](https://nacos.io/zh-cn/index.html)

-

-[dubbo官网](http://dubbo.apache.org/en-us/)

-

-[seata官网](http://seata.io/zh-cn/)

+Placeholder. DO NOT DELETE.

\ No newline at end of file

diff --git a/blog/seata-nacos-docker.md b/blog/seata-nacos-docker.md

index 984953f429..e872b67af1 100644

--- a/blog/seata-nacos-docker.md

+++ b/blog/seata-nacos-docker.md

@@ -1,576 +1 @@

----

-title: Docker部署Seata与Nacos整合

-keywords: [Seata,Nacos,分布式事务]

-description: 本文讲述如何使用Seata整合Nacos配置的Docker部署

-author: FUNKYE

-date: 2019/12/03

----

-

-# Docker部署Seata与Nacos整合

-

-运行所使用的demo[项目地址](https://gitee.com/itCjb/springboot-dubbo-mybatisplus-seata )

-

-本文作者:FUNKYE(陈健斌),杭州某互联网公司主程。

-

-# 前言

-

-直连方式的Seata配置[博客](http://seata.io/zh-cn/blog/springboot-dubbo-mybatisplus-seata.html)

-

-Seata整合Nacos配置[博客](http://seata.io/zh-cn/blog/seata-nacos-analysis.html)

-

-我们接着前几篇篇的基础上去配置nacos做配置中心跟dubbo注册中心.

-

-## 准备工作

-

- 1.安装docker

-

-```shell

-yum -y install docker

-```

-

- 2.创建nacos与seata的数据库

-

-```mysql

-/******************************************/

-/* 数据库全名 = nacos */

-/* 表名称 = config_info */

-/******************************************/

-CREATE TABLE `config_info` (

- `id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'id',

- `data_id` varchar(255) NOT NULL COMMENT 'data_id',

- `group_id` varchar(255) DEFAULT NULL,

- `content` longtext NOT NULL COMMENT 'content',

- `md5` varchar(32) DEFAULT NULL COMMENT 'md5',

- `gmt_create` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '创建时间',

- `gmt_modified` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '修改时间',

- `src_user` text COMMENT 'source user',

- `src_ip` varchar(20) DEFAULT NULL COMMENT 'source ip',

- `app_name` varchar(128) DEFAULT NULL,

- `tenant_id` varchar(128) DEFAULT '' COMMENT '租户字段',

- `c_desc` varchar(256) DEFAULT NULL,

- `c_use` varchar(64) DEFAULT NULL,

- `effect` varchar(64) DEFAULT NULL,

- `type` varchar(64) DEFAULT NULL,

- `c_schema` text,

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_configinfo_datagrouptenant` (`data_id`,`group_id`,`tenant_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='config_info';

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = config_info_aggr */

-/******************************************/

-CREATE TABLE `config_info_aggr` (

- `id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'id',

- `data_id` varchar(255) NOT NULL COMMENT 'data_id',

- `group_id` varchar(255) NOT NULL COMMENT 'group_id',

- `datum_id` varchar(255) NOT NULL COMMENT 'datum_id',

- `content` longtext NOT NULL COMMENT '内容',

- `gmt_modified` datetime NOT NULL COMMENT '修改时间',

- `app_name` varchar(128) DEFAULT NULL,

- `tenant_id` varchar(128) DEFAULT '' COMMENT '租户字段',

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_configinfoaggr_datagrouptenantdatum` (`data_id`,`group_id`,`tenant_id`,`datum_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='增加租户字段';

-

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = config_info_beta */

-/******************************************/

-CREATE TABLE `config_info_beta` (

- `id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'id',

- `data_id` varchar(255) NOT NULL COMMENT 'data_id',

- `group_id` varchar(128) NOT NULL COMMENT 'group_id',

- `app_name` varchar(128) DEFAULT NULL COMMENT 'app_name',

- `content` longtext NOT NULL COMMENT 'content',

- `beta_ips` varchar(1024) DEFAULT NULL COMMENT 'betaIps',

- `md5` varchar(32) DEFAULT NULL COMMENT 'md5',

- `gmt_create` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '创建时间',

- `gmt_modified` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '修改时间',

- `src_user` text COMMENT 'source user',

- `src_ip` varchar(20) DEFAULT NULL COMMENT 'source ip',

- `tenant_id` varchar(128) DEFAULT '' COMMENT '租户字段',

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_configinfobeta_datagrouptenant` (`data_id`,`group_id`,`tenant_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='config_info_beta';

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = config_info_tag */

-/******************************************/

-CREATE TABLE `config_info_tag` (

- `id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'id',

- `data_id` varchar(255) NOT NULL COMMENT 'data_id',

- `group_id` varchar(128) NOT NULL COMMENT 'group_id',

- `tenant_id` varchar(128) DEFAULT '' COMMENT 'tenant_id',

- `tag_id` varchar(128) NOT NULL COMMENT 'tag_id',

- `app_name` varchar(128) DEFAULT NULL COMMENT 'app_name',

- `content` longtext NOT NULL COMMENT 'content',

- `md5` varchar(32) DEFAULT NULL COMMENT 'md5',

- `gmt_create` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '创建时间',

- `gmt_modified` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '修改时间',

- `src_user` text COMMENT 'source user',

- `src_ip` varchar(20) DEFAULT NULL COMMENT 'source ip',

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_configinfotag_datagrouptenanttag` (`data_id`,`group_id`,`tenant_id`,`tag_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='config_info_tag';

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = config_tags_relation */

-/******************************************/

-CREATE TABLE `config_tags_relation` (

- `id` bigint(20) NOT NULL COMMENT 'id',

- `tag_name` varchar(128) NOT NULL COMMENT 'tag_name',

- `tag_type` varchar(64) DEFAULT NULL COMMENT 'tag_type',

- `data_id` varchar(255) NOT NULL COMMENT 'data_id',

- `group_id` varchar(128) NOT NULL COMMENT 'group_id',

- `tenant_id` varchar(128) DEFAULT '' COMMENT 'tenant_id',

- `nid` bigint(20) NOT NULL AUTO_INCREMENT,

- PRIMARY KEY (`nid`),

- UNIQUE KEY `uk_configtagrelation_configidtag` (`id`,`tag_name`,`tag_type`),

- KEY `idx_tenant_id` (`tenant_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='config_tag_relation';

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = group_capacity */

-/******************************************/

-CREATE TABLE `group_capacity` (

- `id` bigint(20) unsigned NOT NULL AUTO_INCREMENT COMMENT '主键ID',

- `group_id` varchar(128) NOT NULL DEFAULT '' COMMENT 'Group ID,空字符表示整个集群',

- `quota` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '配额,0表示使用默认值',

- `usage` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '使用量',

- `max_size` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '单个配置大小上限,单位为字节,0表示使用默认值',

- `max_aggr_count` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '聚合子配置最大个数,,0表示使用默认值',

- `max_aggr_size` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '单个聚合数据的子配置大小上限,单位为字节,0表示使用默认值',

- `max_history_count` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '最大变更历史数量',

- `gmt_create` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '创建时间',

- `gmt_modified` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '修改时间',

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_group_id` (`group_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='集群、各Group容量信息表';

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = his_config_info */

-/******************************************/

-CREATE TABLE `his_config_info` (

- `id` bigint(64) unsigned NOT NULL,

- `nid` bigint(20) unsigned NOT NULL AUTO_INCREMENT,

- `data_id` varchar(255) NOT NULL,

- `group_id` varchar(128) NOT NULL,

- `app_name` varchar(128) DEFAULT NULL COMMENT 'app_name',

- `content` longtext NOT NULL,

- `md5` varchar(32) DEFAULT NULL,

- `gmt_create` datetime NOT NULL DEFAULT '2010-05-05 00:00:00',

- `gmt_modified` datetime NOT NULL DEFAULT '2010-05-05 00:00:00',

- `src_user` text,

- `src_ip` varchar(20) DEFAULT NULL,

- `op_type` char(10) DEFAULT NULL,

- `tenant_id` varchar(128) DEFAULT '' COMMENT '租户字段',

- PRIMARY KEY (`nid`),

- KEY `idx_gmt_create` (`gmt_create`),

- KEY `idx_gmt_modified` (`gmt_modified`),

- KEY `idx_did` (`data_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='多租户改造';

-

-

-/******************************************/

-/* 数据库全名 = nacos_config */

-/* 表名称 = tenant_capacity */

-/******************************************/

-CREATE TABLE `tenant_capacity` (

- `id` bigint(20) unsigned NOT NULL AUTO_INCREMENT COMMENT '主键ID',

- `tenant_id` varchar(128) NOT NULL DEFAULT '' COMMENT 'Tenant ID',

- `quota` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '配额,0表示使用默认值',

- `usage` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '使用量',

- `max_size` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '单个配置大小上限,单位为字节,0表示使用默认值',

- `max_aggr_count` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '聚合子配置最大个数',

- `max_aggr_size` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '单个聚合数据的子配置大小上限,单位为字节,0表示使用默认值',

- `max_history_count` int(10) unsigned NOT NULL DEFAULT '0' COMMENT '最大变更历史数量',

- `gmt_create` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '创建时间',

- `gmt_modified` datetime NOT NULL DEFAULT '2010-05-05 00:00:00' COMMENT '修改时间',

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_tenant_id` (`tenant_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='租户容量信息表';

-

-

-CREATE TABLE `tenant_info` (

- `id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'id',

- `kp` varchar(128) NOT NULL COMMENT 'kp',

- `tenant_id` varchar(128) default '' COMMENT 'tenant_id',

- `tenant_name` varchar(128) default '' COMMENT 'tenant_name',

- `tenant_desc` varchar(256) DEFAULT NULL COMMENT 'tenant_desc',

- `create_source` varchar(32) DEFAULT NULL COMMENT 'create_source',

- `gmt_create` bigint(20) NOT NULL COMMENT '创建时间',

- `gmt_modified` bigint(20) NOT NULL COMMENT '修改时间',

- PRIMARY KEY (`id`),

- UNIQUE KEY `uk_tenant_info_kptenantid` (`kp`,`tenant_id`),

- KEY `idx_tenant_id` (`tenant_id`)

-) ENGINE=InnoDB DEFAULT CHARSET=utf8 COLLATE=utf8_bin COMMENT='tenant_info';

-

-CREATE TABLE users (

- username varchar(50) NOT NULL PRIMARY KEY,

- password varchar(500) NOT NULL,

- enabled boolean NOT NULL

-);

-

-CREATE TABLE roles (

- username varchar(50) NOT NULL,

- role varchar(50) NOT NULL

-);

-

-INSERT INTO users (username, password, enabled) VALUES ('nacos', '$2a$10$EuWPZHzz32dJN7jexM34MOeYirDdFAZm2kuWj7VEOJhhZkDrxfvUu', TRUE);

-

-INSERT INTO roles (username, role) VALUES ('nacos', 'ROLE_ADMIN');

-

-```

-

-```mysql

--- the table to store GlobalSession data

-CREATE TABLE IF NOT EXISTS `global_table`

-(

- `xid` VARCHAR(128) NOT NULL,

- `transaction_id` BIGINT,

- `status` TINYINT NOT NULL,

- `application_id` VARCHAR(32),

- `transaction_service_group` VARCHAR(32),

- `transaction_name` VARCHAR(128),

- `timeout` INT,

- `begin_time` BIGINT,

- `application_data` VARCHAR(2000),

- `gmt_create` DATETIME,

- `gmt_modified` DATETIME,

- PRIMARY KEY (`xid`),

- KEY `idx_gmt_modified_status` (`gmt_modified`, `status`),

- KEY `idx_transaction_id` (`transaction_id`)

-) ENGINE = InnoDB

- DEFAULT CHARSET = utf8;

-

--- the table to store BranchSession data

-CREATE TABLE IF NOT EXISTS `branch_table`

-(

- `branch_id` BIGINT NOT NULL,

- `xid` VARCHAR(128) NOT NULL,

- `transaction_id` BIGINT,

- `resource_group_id` VARCHAR(32),

- `resource_id` VARCHAR(256),

- `branch_type` VARCHAR(8),

- `status` TINYINT,

- `client_id` VARCHAR(64),

- `application_data` VARCHAR(2000),

- `gmt_create` DATETIME(6),

- `gmt_modified` DATETIME(6),

- PRIMARY KEY (`branch_id`),

- KEY `idx_xid` (`xid`)

-) ENGINE = InnoDB

- DEFAULT CHARSET = utf8;

-

--- the table to store lock data

-CREATE TABLE IF NOT EXISTS `lock_table`

-(

- `row_key` VARCHAR(128) NOT NULL,

- `xid` VARCHAR(128),

- `transaction_id` BIGINT,

- `branch_id` BIGINT NOT NULL,

- `resource_id` VARCHAR(256),

- `table_name` VARCHAR(32),

- `pk` VARCHAR(36),

- `gmt_create` DATETIME,

- `gmt_modified` DATETIME,

- PRIMARY KEY (`row_key`),

- KEY `idx_branch_id` (`branch_id`)

-) ENGINE = InnoDB

- DEFAULT CHARSET = utf8;

-

-```

-

- 3.拉取nacos以及seata镜像并运行

-

-```shell

-docker run -d --name nacos -p 8848:8848 -e MODE=standalone -e MYSQL_MASTER_SERVICE_HOST=你的mysql所在ip -e MYSQL_MASTER_SERVICE_DB_NAME=nacos -e MYSQL_MASTER_SERVICE_USER=root -e MYSQL_MASTER_SERVICE_PASSWORD=mysql密码 -e MYSQL_SLAVE_SERVICE_HOST=你的mysql所在ip -e SPRING_DATASOURCE_PLATFORM=mysql -e MYSQL_DATABASE_NUM=1 nacos/nacos-server:latest

-```

-

-```shell

-docker run -d --name seata -p 8091:8091 -e SEATA_IP=你想指定的ip -e SEATA_PORT=8091 seataio/seata-server:1.4.2

-```

-

-## Seata配置

-

- 1.由于seata容器内没有内置vim,我们可以直接将要文件夹cp到宿主机外来编辑好了,再cp回去

-

-```

-docker cp 容器id:seata-server/resources 你想放置的目录

-```

-

- 2.使用如下代码获取两个容器的ip地址

-

-```

-docker inspect --format='{{.NetworkSettings.IPAddress}}' ID/NAMES

-```

-

- 3.nacos-config.txt编辑为如下内容

-

-```

-transport.type=TCP

-transport.server=NIO

-transport.heartbeat=true

-transport.enableClientBatchSendRequest=false

-transport.threadFactory.bossThreadPrefix=NettyBoss

-transport.threadFactory.workerThreadPrefix=NettyServerNIOWorker

-transport.threadFactory.serverExecutorThreadPrefix=NettyServerBizHandler

-transport.threadFactory.shareBossWorker=false

-transport.threadFactory.clientSelectorThreadPrefix=NettyClientSelector

-transport.threadFactory.clientSelectorThreadSize=1

-transport.threadFactory.clientWorkerThreadPrefix=NettyClientWorkerThread

-transport.threadFactory.bossThreadSize=1

-transport.threadFactory.workerThreadSize=default

-transport.shutdown.wait=3

-service.vgroupMapping.你的事务组名=default

-service.default.grouplist=127.0.0.1:8091

-service.enableDegrade=false

-service.disableGlobalTransaction=false

-client.rm.asyncCommitBufferLimit=10000

-client.rm.lock.retryInterval=10

-client.rm.lock.retryTimes=30

-client.rm.lock.retryPolicyBranchRollbackOnConflict=true

-client.rm.reportRetryCount=5

-client.rm.tableMetaCheckEnable=false

-client.rm.tableMetaCheckerInterval=60000

-client.rm.sqlParserType=druid

-client.rm.reportSuccessEnable=false

-client.rm.sagaBranchRegisterEnable=false

-client.tm.commitRetryCount=5

-client.tm.rollbackRetryCount=5

-client.tm.defaultGlobalTransactionTimeout=60000

-client.tm.degradeCheck=false

-client.tm.degradeCheckAllowTimes=10

-client.tm.degradeCheckPeriod=2000

-store.mode=file

-store.publicKey=

-store.file.dir=file_store/data

-store.file.maxBranchSessionSize=16384

-store.file.maxGlobalSessionSize=512

-store.file.fileWriteBufferCacheSize=16384

-store.file.flushDiskMode=async

-store.file.sessionReloadReadSize=100

-store.db.datasource=druid

-store.db.dbType=mysql

-store.db.driverClassName=com.mysql.jdbc.Driver

-store.db.url=jdbc:mysql://你的mysql所在ip:3306/seata?useUnicode=true&rewriteBatchedStatements=true

-store.db.user=mysql账号

-store.db.password=mysql密码

-store.db.minConn=5

-store.db.maxConn=30

-store.db.globalTable=global_table

-store.db.branchTable=branch_table

-store.db.queryLimit=100

-store.db.lockTable=lock_table

-store.db.maxWait=5000

-server.recovery.committingRetryPeriod=1000

-server.recovery.asynCommittingRetryPeriod=1000

-server.recovery.rollbackingRetryPeriod=1000

-server.recovery.timeoutRetryPeriod=1000

-server.maxCommitRetryTimeout=-1

-server.maxRollbackRetryTimeout=-1

-server.rollbackRetryTimeoutUnlockEnable=false

-client.undo.dataValidation=true

-client.undo.logSerialization=jackson

-client.undo.onlyCareUpdateColumns=true

-server.undo.logSaveDays=7

-server.undo.logDeletePeriod=86400000

-client.undo.logTable=undo_log

-client.undo.compress.enable=true

-client.undo.compress.type=zip

-client.undo.compress.threshold=64k

-log.exceptionRate=100

-transport.serialization=seata

-transport.compressor=none

-metrics.enabled=false

-metrics.registryType=compact

-metrics.exporterList=prometheus

-metrics.exporterPrometheusPort=9898

-```

-

-详细参数配置请点[此处](http://seata.io/zh-cn/docs/user/configurations.html)

-

- 4.registry.conf编辑为如下内容

-

-```

-registry {

- # file 、nacos 、eureka、redis、zk、consul、etcd3、sofa

- type = "nacos"

-

- nacos {

- serverAddr = "nacos容器ip:8848"

- namespace = ""

- cluster = "default"

- }

-}

-

-config {

- # file、nacos 、apollo、zk、consul、etcd3

- type = "nacos"

-

- nacos {

- serverAddr = "nacos容器ip:8848"

- namespace = ""

- }

-}

-```

-

- 5.配置完成后使用如下命令,把修改完成的registry.conf复制到容器中,并重启查看日志运行

-

-```shell

-docker cp /home/seata/resources/registry.conf seata:seata-server/resources/

-docker restart seata

-docker logs -f seata

-```

-

- 6.运行nacos-config.sh导入Nacos配置

-

-eg: sh ${SEATAPATH}/script/config-center/nacos/nacos-config.sh -h localhost -p 8848 -g SEATA_GROUP -t 5a3c7d6c-f497-4d68-a71a-2e5e3340b3ca -u username -w password

-

-具体参数释义参考:[配置导入说明](https://github.com/seata/seata/blob/1.4.2/script/config-center/README.md)

-

-

- 7.登录nacos控制中心查看

-

-

-

- 如图所示便是成功了.

-

-# 进行调试

-

- 1.拉取博文中所示的项目,修改test-service的application.yml与registry.conf

-

-```

-registry {

- type = "nacos"

- nacos {

- serverAddr = "宿主机ip:8848"

- namespace = ""

- cluster = "default"

- }

-}

-config {

- type = "nacos"

- nacos {

- serverAddr = "宿主机ip:8848"

- namespace = ""

- cluster = "default"

- }

-}

-

-```

-

-```

-server:

- port: 38888

-spring:

- application:

- name: test-service

- datasource:

- type: com.alibaba.druid.pool.DruidDataSource

- url: jdbc:mysql://mysqlip:3306/test?useUnicode=true&characterEncoding=UTF-8&serverTimezone=UTC

- driver-class-name: com.mysql.cj.jdbc.Driver

- username: root

- password: 123456

-dubbo:

- protocol:

- threadpool: cached

- scan:

- base-packages: com.example

- application:

- qos-enable: false

- name: testserver

- registry:

- id: my-registry

- address: nacos://宿主机ip:8848

-mybatis-plus:

- mapper-locations: classpath:/mapper/*Mapper.xml

- typeAliasesPackage: org.test.entity

- global-config:

- db-config:

- field-strategy: not-empty

- id-type: auto

- db-type: mysql

- configuration:

- map-underscore-to-camel-case: true

- cache-enabled: true

- log-impl: org.apache.ibatis.logging.stdout.StdOutImpl

- auto-mapping-unknown-column-behavior: none

-```

-

- 2.把修改完成的registry.conf复制到test-client-resources中,并修改application

-

-```

-spring:

- application:

- name: test

- datasource:

- driver-class-name: com.mysql.cj.jdbc.Driver

- url: jdbc:mysql://mysqlIp:3306/test?userSSL=true&useUnicode=true&characterEncoding=UTF8&serverTimezone=Asia/Shanghai

- username: root

- password: 123456

- mvc:

- servlet:

- load-on-startup: 1

- http:

- encoding:

- force: true

- charset: utf-8

- enabled: true

- multipart:

- max-file-size: 10MB

- max-request-size: 10MB

-dubbo:

- registry:

- id: my-registry

- address: nacos://宿主机ip:8848

- application:

- name: dubbo-demo-client

- qos-enable: false

-server:

- port: 28888

- max-http-header-size: 8192

- address: 0.0.0.0

- tomcat:

- max-http-post-size: 104857600

-```

- 4. 在每个所涉及的 db 执行 undo_log 脚本.

-```sql

-CREATE TABLE IF NOT EXISTS `undo_log`

-(

- `branch_id` BIGINT NOT NULL COMMENT 'branch transaction id',

- `xid` VARCHAR(128) NOT NULL COMMENT 'global transaction id',

- `context` VARCHAR(128) NOT NULL COMMENT 'undo_log context,such as serialization',

- `rollback_info` LONGBLOB NOT NULL COMMENT 'rollback info',

- `log_status` INT(11) NOT NULL COMMENT '0:normal status,1:defense status',

- `log_created` DATETIME(6) NOT NULL COMMENT 'create datetime',

- `log_modified` DATETIME(6) NOT NULL COMMENT 'modify datetime',

- UNIQUE KEY `ux_undo_log` (`xid`, `branch_id`)

-) ENGINE = InnoDB

- AUTO_INCREMENT = 1

- DEFAULT CHARSET = utf8 COMMENT ='AT transaction mode undo table';

-```

-

- 5.依次运行test-service,test-client.

-

- 6.查看nacos中服务列表是否如下图所示

-

-

-

-# 总结

-

-关于nacos与seata的docker部署已经完成了,更详细的内容希望希望大家访问以下地址阅读详细文档

-

-[nacos官网](https://nacos.io/zh-cn/index.html)

-

-[dubbo官网](http://dubbo.apache.org/en-us/)

-

-[seata官网](http://seata.io/zh-cn/)

-

-[docker官网](https://www.docker.com/)

\ No newline at end of file

+Placeholder. DO NOT DELETE.

\ No newline at end of file

diff --git a/blog/seata-observable-practice.md b/blog/seata-observable-practice.md

index 31397eccb9..e872b67af1 100644

--- a/blog/seata-observable-practice.md

+++ b/blog/seata-observable-practice.md

@@ -1,141 +1 @@

----

-title: Seata的可观测实践

-keywords: [Seata、分布式事务、数据一致性、微服务、可观测]

-description: 本文介绍Seata在可观测领域的探索和实践

-author: 刘戎-Seata

-date: 2023/06/25

----

-

-## Seata简介

-Seata的前身是阿里巴巴集团内大规模使用保证分布式事务一致性的中间件,Seata是其开源产品,由社区维护。在介绍Seata前,先与大家讨论下我们业务发展过程中经常遇到的一些问题场景。

-### 业务场景

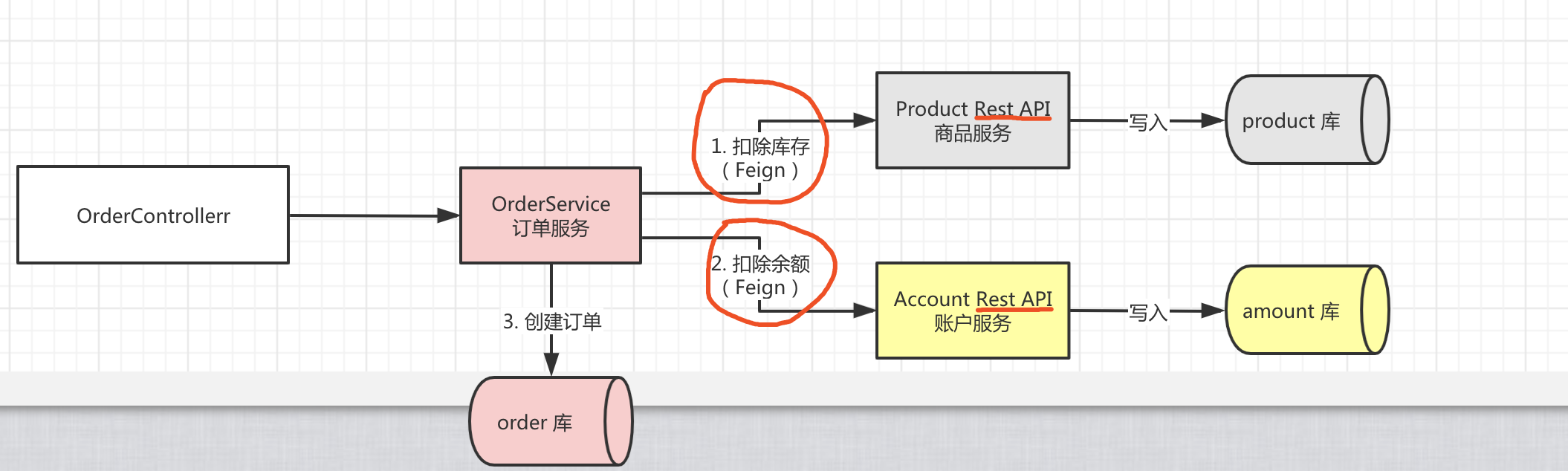

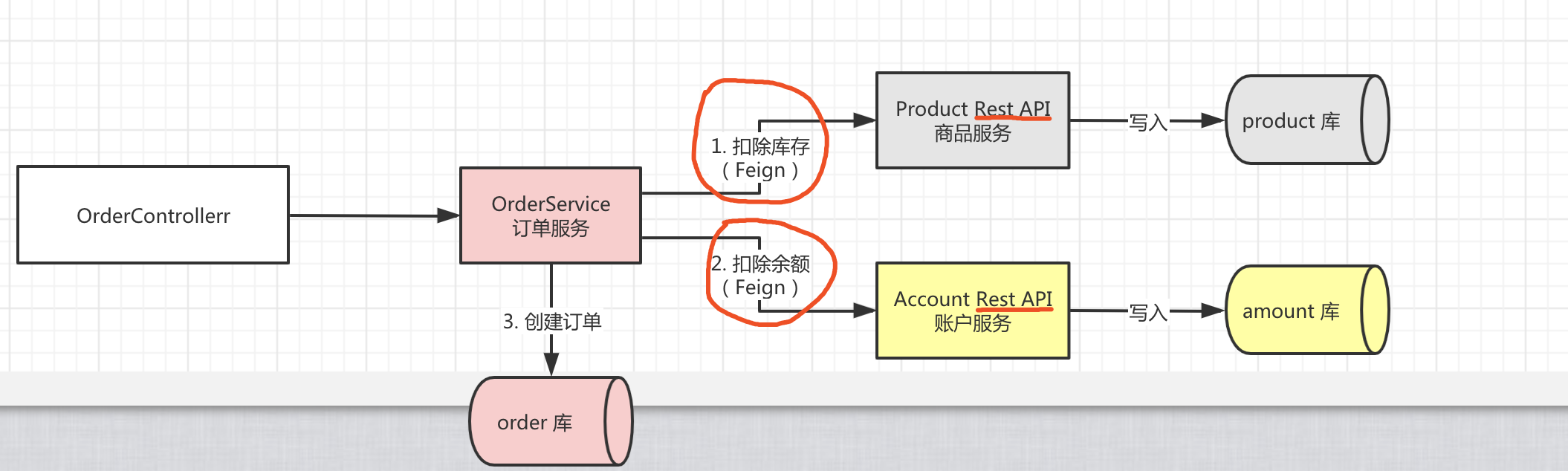

-我们业务在发展的过程中,基本上都是从一个简单的应用,逐渐过渡到规模庞大、业务复杂的应用。这些复杂的场景难免遇到分布式事务管理问题,Seata的出现正是解决这些分布式场景下的事务管理问题。介绍下其中几个经典的场景:

-#### 场景一:分库分表场景下的分布式事务

-

-起初我们的业务规模小、轻量化,单一数据库就能保障我们的数据链路。但随着业务规模不断扩大、业务不断复杂化,通常单一数据库在容量、性能上会遭遇瓶颈。通常的解决方案是向分库、分表的架构演进。此时,即引入了**分库分表场景下**的分布式事务场景。

-#### 场景二:跨服务场景下的分布式事务

-

-降低单体应用复杂度的方案:应用微服务化拆分。拆分后,我们的产品由多个功能各异的微服务组件构成,每个微服务都使用独立的数据库资源。在涉及到跨服务调用的数据一致性场景时,就引入了**跨服务场景下**的分布式事务。

-### Seata架构

-

-其核心组件主要如下:

-

-- **Transaction Coordinator(TC)**

-

-事务协调器,维护全局事务的运行状态,负责协调并驱动全局事务的提交或回滚。

-

-- **Transaction Manager(TM)**

-

-控制全局事务的边界,负责开启一个全局事务,并最终发起全局提交或全局回滚的决议,TM定义全局事务的边界。

-

-- **Resource Manager(RM)**

-

-控制分支事务,负责分支注册、状态汇报,并接收事务协调器的指令,驱动分支(本地)事务的提交和回滚。RM负责定义分支事务的边界和行为。

-## Seata的可观测实践

-### 为什么需要可观测?

-

-- **分布式事务消息链路较复杂**

-

-Seata在解决了用户易用性和分布式事务一致性这些问题的同时,需要多次TC与TM、RM之间的交互,尤其当微服务的链路变复杂时,Seata的交互链路也会呈正相关性增加。这种情况下,其实我们就需要引入可观测的能力来观察、分析事物链路。

-

-- **异常链路、故障排查难定位,性能优化无从下手**

-

-在排查Seata的异常事务链路时,传统的方法需要看日志,这样检索起来比较麻烦。在引入可观测能力后,帮助我们直观的分析链路,快速定位问题;为优化耗时的事务链路提供依据。

-

-- **可视化、数据可量化**

-

-可视化能力可让用户对事务执行情况有直观的感受;借助可量化的数据,可帮助用户评估资源消耗、规划预算。

-### 可观测能力概览

-| **可观测维度** | **seata期望的能力** | **技术选型参考** |

-| --- | --- | --- |

-| Metrics | 功能层面:可按业务分组隔离,采集事务总量、耗时等重要指标

-性能层面:高度量性能,插件按需加载

-架构层面:减少第三方依赖,服务端、客户端能够采用统一的架构,减少技术复杂度

-兼容性层面:至少兼容Prometheus生态 | Prometheus:指标存储和查询等领域有着业界领先的地位

-OpenTelemetry:可观测数据采集和规范的事实标准。但自身并不负责数据的存储,展示和分析 |

-| Tracing | 功能层面:全链路追踪分布式事务生命周期,反应分布式事务执行性能消耗

-易用性方面:对使用seata的用户而言简单易接入 | SkyWalking:利用Java的Agent探针技术,效率高,简单易用。 |

-| Logging | 功能层面:记录服务端、客户端全部生命周期信息

-易用性层面:能根据XID快速匹配全局事务对应链路日志 | Alibaba Cloud Service

-ELK |

-

-### Metrics维度

-#### 设计思路

-

-1. Seata作为一个被集成的数据一致性框架,Metrics模块将尽可能少的使用第三方依赖以降低发生冲突的风险

-2. Metrics模块将竭力争取更高的度量性能和更低的资源开销,尽可能降低开启后带来的副作用

-3. 配置时,Metrics是否激活、数据如何发布,取决于对应的配置;开启配置则自动启用,并默认将度量数据通过prometheusexporter的形式发布

-4. 不使用Spring,使用SPI(Service Provider Interface)加载扩展

-#### 模块设计

-

-

-- seata-metrics-core:Metrics核心模块,根据配置组织(加载)1个Registry和N个Exporter;

-- seata-metrics-api:定义了Meter指标接口,Registry指标注册中心接口;

-- seata-metrics-exporter-prometheus:内置的prometheus-exporter实现;

-- seata-metrics-registry-compact:内置的Registry实现,并轻量级实现了Gauge、Counter、Summay、Timer指标;

-#### metrics模块工作流

-

-上图是metrics模块的工作流,其工作流程如下:

-

-1. 利用SPI机制,根据配置加载Exporter和Registry的实现类;

-2. 基于消息订阅与通知机制,监听所有全局事务的状态变更事件,并publish到EventBus;

-3. 事件订阅者消费事件,并将生成的metrics写入Registry;

-4. 监控系统(如prometheus)从Exporter中拉取数据。

-#### TC核心指标

-

-#### TM核心指标

-

-#### RM核心指标

-

-#### 大盘展示

-

-### Tracing维度

-#### Seata为什么需要tracing?

-

-1. 对业务侧而言,引入Seata后,对业务性能会带来多大损耗?主要时间消耗在什么地方?如何针对性的优化业务逻辑?这些都是未知的。

-2. Seata的所有消息记录都通过日志持久化落盘,但对不了解Seata的用户而言,日志非常不友好。能否通过接入Tracing,提升事务链路排查效率?

-3. 对于新手用户,可通过Tracing记录,快速了解seata的工作原理,降低seata使用门槛。

-#### Seata的tracing解决方案

-

-- Seata在自定义的RPC消息协议中定义了Header信息;

-- SkyWalking拦截指定的RPC消息,并注入tracing相关的span信息;

-- 以RPC消息的发出&接收为临界点,定义了span的生命周期范围。

-

-基于上述的方式,Seata实现了事务全链路的tracing,具体接入可参考[为[Seata应用 | Seata-server]接入Skywalking](https://seata.io/zh-cn/docs/user/apm/skywalking.html)。

-#### tracing效果

-

-- 基于的demo场景:

-1. 用户请求交易服务

-2. 交易服务锁定库存

-3. 交易服务创建账单

-4. 账单服务进行扣款

-

-

-

-- GlobalCommit成功的事务链路(事例)

-

-

-

-

-### Logging维度

-#### 设计思路

-

-Logging这一块其实承担的是可观测这几个维度当中的兜底角色。放在最底层的,其实就是我们日志格式的设计,只有好日志格式,我们才能对它进行更好的采集、模块化的存储和展示。在其之上,是日志的采集、存储、监控、告警、数据可视化,这些模块更多的是有现成的工具,比如阿里的SLS日志服务、还有ELK的一套技术栈,我们更多是将开销成本、接入复杂度、生态繁荣度等作为考量。

-#### 日志格式设计

-这里拿Seata-Server的一个日志格式作为案例:

-

-

-- 线程池规范命名:当线程池、线程比较多时,规范的线程命名能将无序执行的线程执行次序清晰展示。

-- 方法全类名可追溯:快速定位到具体的代码块。

-- 重点运行时信息透出:重点突出关键日志,不关键的日志不打印,减少日志冗余。

-- 消息格式可扩展:通过扩展消息类的输出格式,减少日志的代码修改量。

-## 总结&展望

-#### Metrics

-总结:基本实现分布式事务的可量化、可观测。

-展望:更细粒度的指标、更广阔的生态兼容。

-#### Tracing

-总结:分布式事务全链路的可追溯。

-展望:根据xid追溯事务链路,异常链路根因快速定位。

-#### Logging

-总结:结构化的日志格式。

-展望:日志可观测体系演进。

+Placeholder. DO NOT DELETE.

\ No newline at end of file

diff --git a/blog/seata-quick-start.md b/blog/seata-quick-start.md

index 1a06b25649..e872b67af1 100644

--- a/blog/seata-quick-start.md

+++ b/blog/seata-quick-start.md

@@ -1,340 +1 @@

----

-title: Seata 极简入门

-description: 从 0 开始入门 Seata,搭建 Seata 服务,并接入 Java 项目中实现分布式事务

-keywords: [fescar、seata、分布式事务]

-author: 芋道源码

-date: 2020/04/19

----

-

-- [1. 概述](#)

-- [2. 部署单机 TC Server](#)

-- [3. 部署集群 TC Server](#)

-- [4. 接入 Java 应用](#)

-

-# 1. 概述

-

-[Seata](https://github.com/seata/seata) 是**阿里**开源的一款开源的**分布式事务**解决方案,致力于提供高性能和简单易用的分布式事务服务。

-

-## 1.1 四种事务模式

-

-Seata 目标打造**一站式**的分布事务的解决方案,最终会提供四种事务模式:

-* AT 模式:参见[《Seata AT 模式》](https://seata.io/zh-cn/docs/dev/mode/at-mode.html)文档

-* TCC 模式:参见[《Seata TCC 模式》](https://seata.io/zh-cn/docs/dev/mode/tcc-mode.html)文档

-* Saga 模式:参见[《SEATA Saga 模式》](https://seata.io/zh-cn/docs/dev/mode/saga-mode.html)文档

-* XA 模式:正在开发中...

-

-目前使用的**流行度**情况是:AT > TCC > Saga。因此,我们在学习 Seata 的时候,可以花更多精力在 **AT 模式**上,最好搞懂背后的实现原理,毕竟分布式事务涉及到数据的正确性,出问题需要快速排查定位并解决。

-

-> 友情提示:具体的流行度,胖友可以选择看看 [Wanted: who's using Seata](https://github.com/seata/seata/issues/1246) 每个公司登记的使用方式。

-

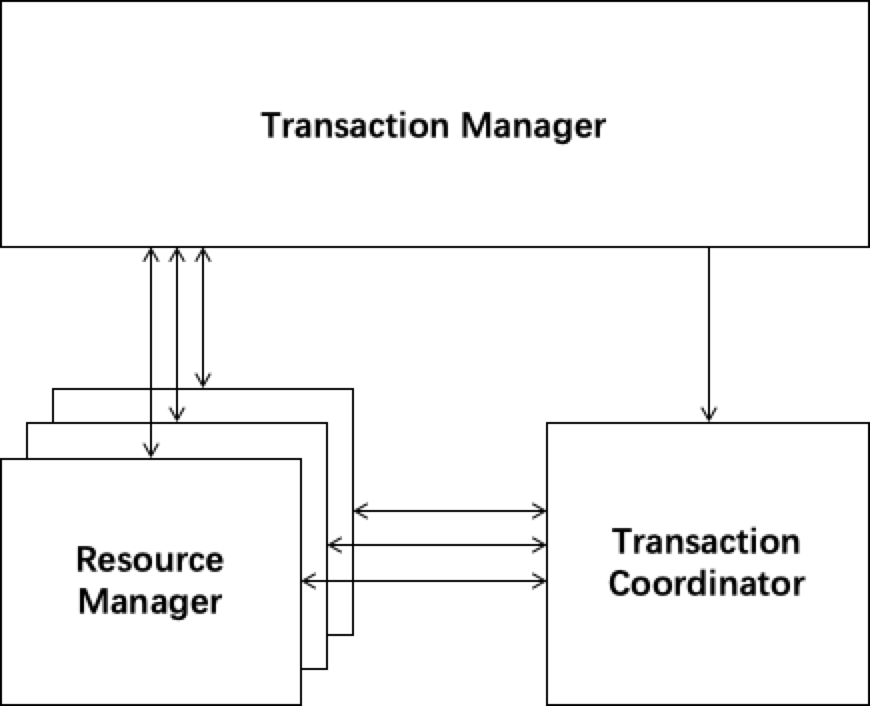

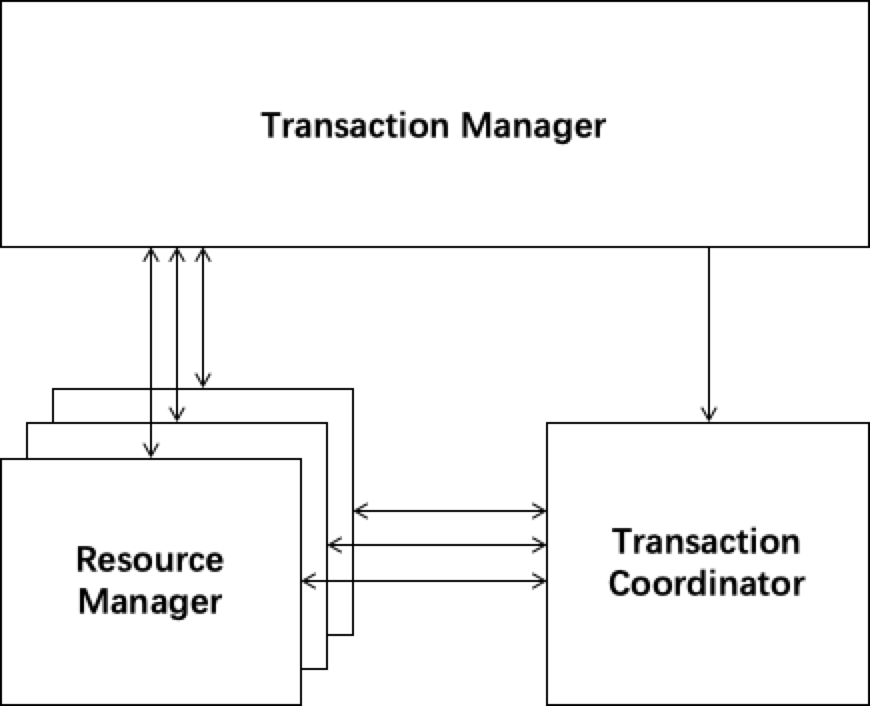

-## 1.2 三种角色

-

-在 Seata 的架构中,一共有三个角色:

-

-

-

-* **TC** (Transaction Coordinator) - 事务协调者:维护全局和分支事务的状态,驱动**全局事务**提交或回滚。

-* **TM** (Transaction Manager) - 事务管理器:定义**全局事务**的范围,开始全局事务、提交或回滚全局事务。

-* **RM** ( Resource Manager ) - 资源管理器:管理**分支事务**处理的资源( Resource ),与 TC 交谈以注册分支事务和报告分支事务的状态,并驱动**分支事务**提交或回滚。

-

-其中,TC 为单独部署的 **Server** 服务端,TM 和 RM 为嵌入到应用中的 **Client** 客户端。

-

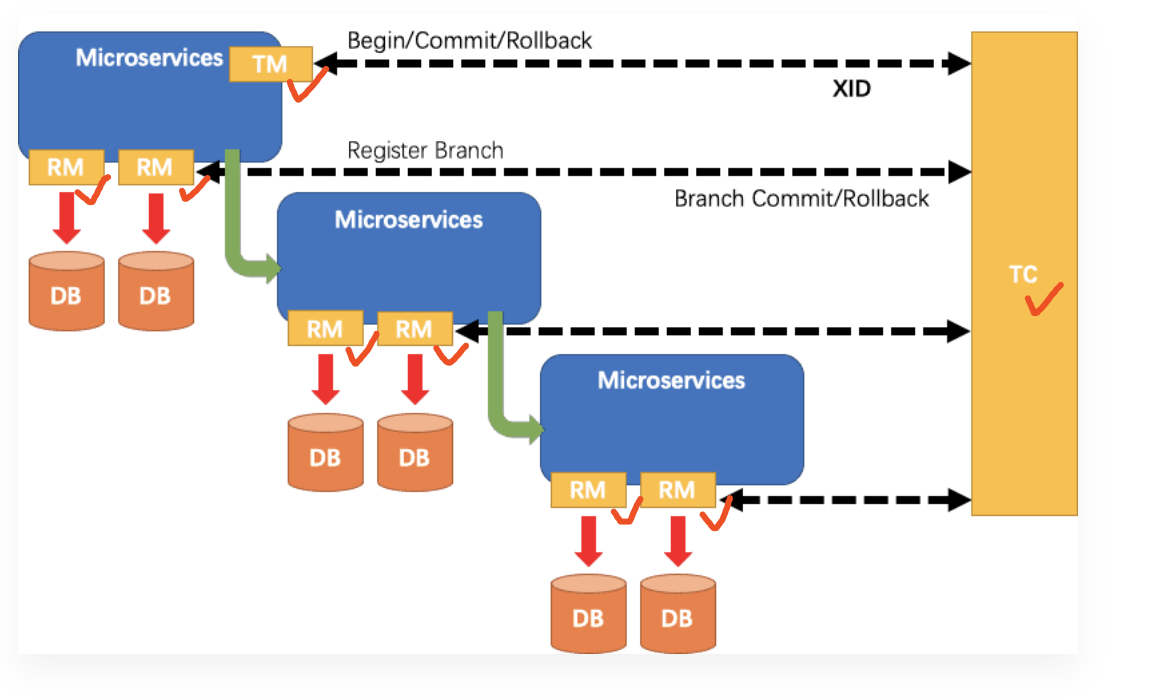

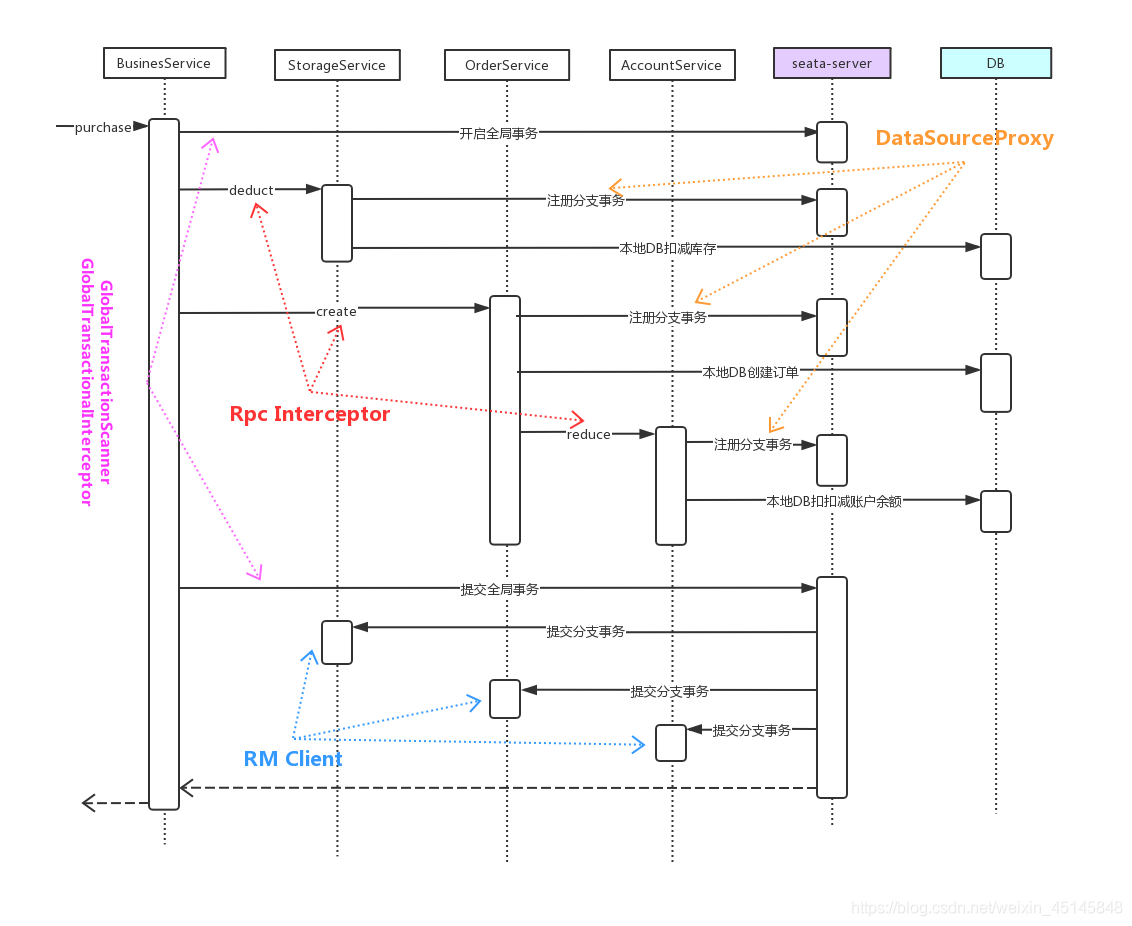

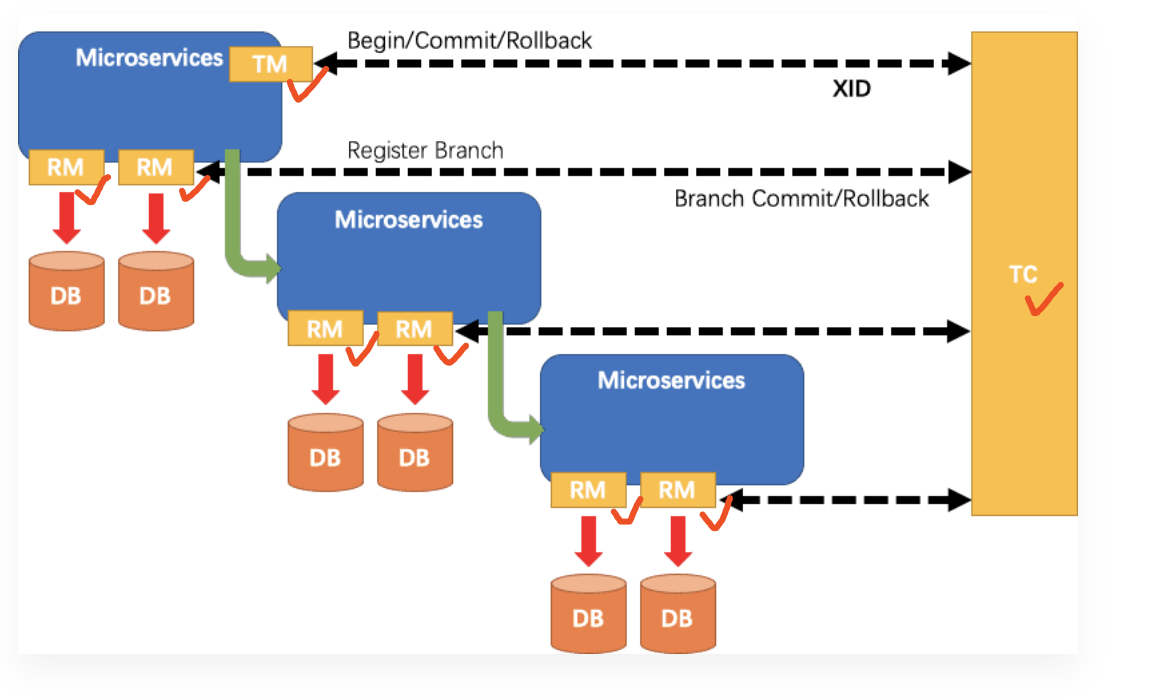

-在 Seata 中,一个分布式事务的**生命周期**如下:

-

-

-

-> 友情提示:看下艿艿添加的红色小勾。

-

-* TM 请求 TC 开启一个全局事务。TC 会生成一个 **XID** 作为该全局事务的编号。

- > **XID**,会在微服务的调用链路中传播,保证将多个微服务的子事务关联在一起。

-

-* RM 请求 TC 将本地事务注册为全局事务的分支事务,通过全局事务的 **XID** 进行关联。

-* TM 请求 TC 告诉 **XID** 对应的全局事务是进行提交还是回滚。

-* TC 驱动 RM 们将 **XID** 对应的自己的本地事务进行提交还是回滚。

-

-## 1.3 框架支持情况

-

-Seata 目前提供了对主流的**微服务框架**的支持:

-* Dubbo

- > 通过 [`seata-dubbo`](https://github.com/seata/seata/blob/develop/integration/dubbo/) 集成

-

-* SOFA-RPC

- > 通过 [`seata-sofa-rpc`](https://github.com/seata/seata/blob/develop/integration/sofa-rpc/) 集成

-

-* Motan

- > 通过 [`seata-motan`](https://github.com/seata/seata/blob/develop/integration/motan/) 集成

-

-* gRPC

- > 通过 [`seata-grpc`](https://github.com/seata/seata/blob/develop/integration/gprc/) 集成

-

-* Apache HttpClient

- > 通过 [`seata-http`](https://github.com/seata/seata/blob/develop/integration/http/) 集成

-

-* Spring Cloud OpenFeign

- > 通过 [`spring-cloud-starter-alibaba-seata`](https://github.com/alibaba/spring-cloud-alibaba/blob/master/spring-cloud-alibaba-starters/spring-cloud-starter-alibaba-seata/src/main/java/com/alibaba/cloud/seata/) 的 [`feign`](https://github.com/alibaba/spring-cloud-alibaba/blob/master/spring-cloud-alibaba-starters/spring-cloud-starter-alibaba-seata/src/main/java/com/alibaba/cloud/seata/feign/) 模块

-

-* Spring RestTemplate

- > 通过 [`spring-cloud-starter-alibaba-seata`](https://github.com/alibaba/spring-cloud-alibaba/blob/master/spring-cloud-alibaba-starters/spring-cloud-starter-alibaba-seata/src/main/java/com/alibaba/cloud/seata/feign/SeataBeanPostProcessor.java) 的 [`rest`](https://github.com/alibaba/spring-cloud-alibaba/blob/master/spring-cloud-alibaba-starters/spring-cloud-starter-alibaba-seata/src/main/java/com/alibaba/cloud/seata/rest/) 模块

-

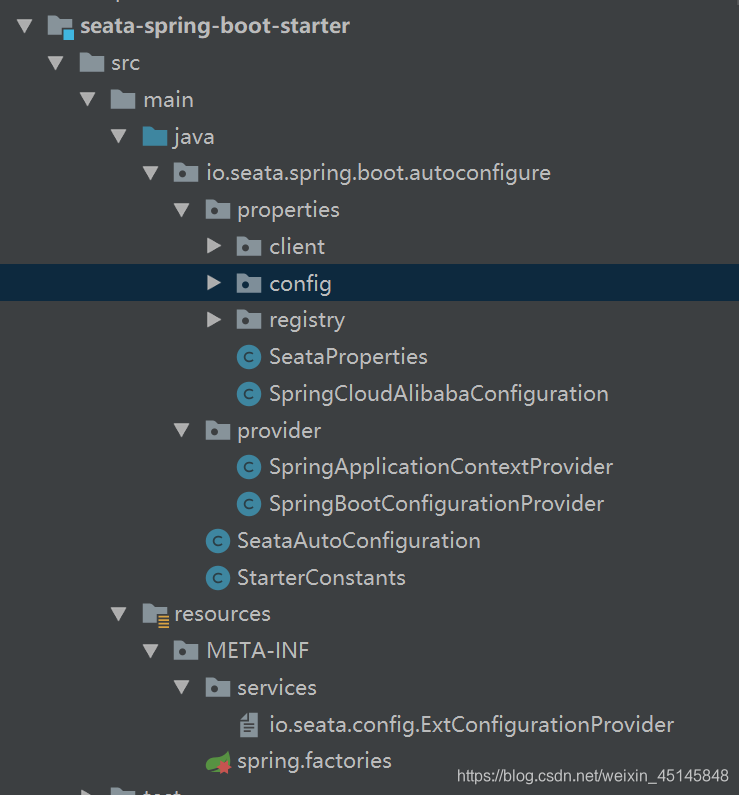

-同时方便我们集成到 Java 项目当中,Seata 也提供了相应的 Starter 库:

-* [`seata-spring-boot-starter`](https://mvnrepository.com/artifact/io.seata/seata-spring-boot-starter)

-* [`spring-cloud-starter-alibaba-seata`](https://mvnrepository.com/artifact/com.alibaba.cloud/spring-cloud-starter-alibaba-seata)

-

-因为 Seata 是基于 [DataSource](https://docs.oracle.com/javase/7/docs/api/javax/sql/DataSource.html) 数据源进行**代理**来拓展,所以天然对主流的 ORM 框架提供了非常好的支持:

-* MyBatis、MyBatis-Plus

-* JPA、Hibernate

-

-## 1.4 案例情况

-

-从 [Wanted: who's using Seata](https://github.com/seata/seata/issues/1246) 的登记情况,Seata 已经在国内很多团队开始落地,其中不乏有滴滴、韵达等大型公司。可汇总如下图:

-

-

-

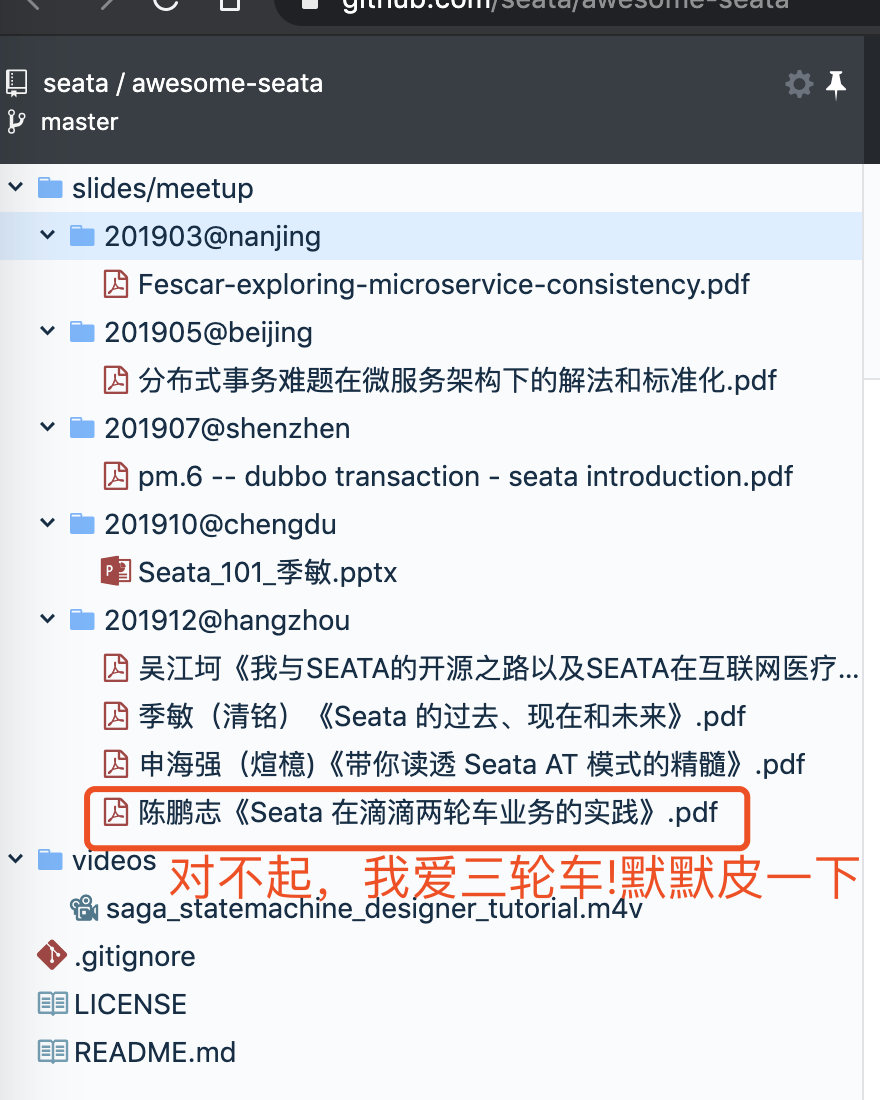

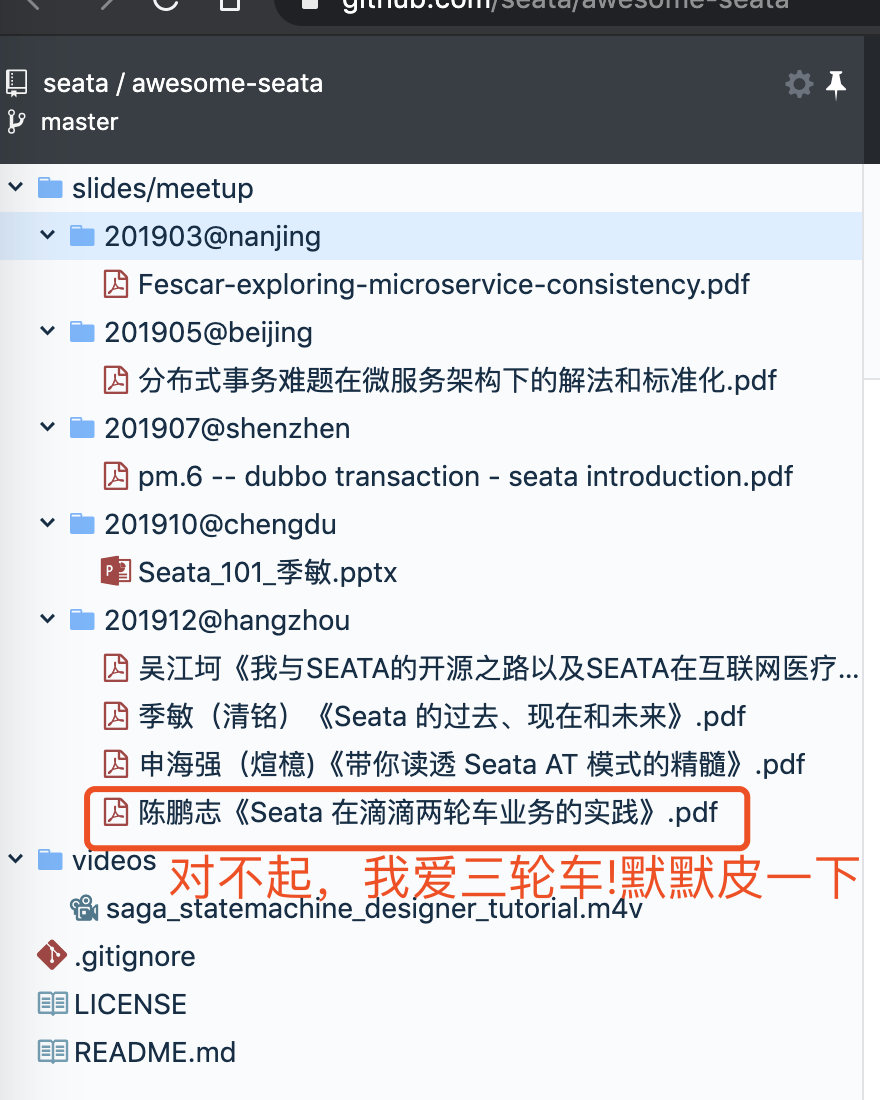

-另外,在 [awesome-seata](https://github.com/seata/awesome-seata) 仓库中,艿艿看到了滴滴等等公司的落地时的技术分享,还是非常真实可靠的。如下图所示:

-

-从案例的情况来说,Seata 可能给是目前已知最可靠的分布式事务解决方案,至少对它进行技术投入是非常不错的选择。

-

-# 2. 部署单机 TC Server

-

-本小节,我们来学习部署**单机** Seata **TC** Server,常用于学习或测试使用,不建议在生产环境中部署单机。

-

-因为 TC 需要进行全局事务和分支事务的记录,所以需要对应的**存储**。目前,TC 有两种存储模式( `store.mode` ):

-

-* file 模式:适合**单机**模式,全局事务会话信息在**内存**中读写,并持久化本地文件 `root.data`,性能较高。

-* db 模式:适合**集群**模式,全局事务会话信息通过 **db** 共享,相对性能差点。

-

-显然,我们将采用 file 模式,最终我们部署单机 TC Server 如下图所示:

-

-哔哔完这么多,我们开始正式部署单机 TC Server,这里艿艿使用 macOS 系统,和 Linux、Windows 是差不多的,胖友脑补翻译。

-

-## 2.1 下载 Seata 软件包

-

-打开 [Seata 下载页面](https://github.com/seata/seata/releases),选择想要的 Seata 版本。这里,我们选择 [v1.1.0](https://github.com/seata/seata/releases/tag/v1.1.0) 最新版本。

-

-```Bash

-# 创建目录

-$ mkdir -p /Users/yunai/Seata

-$ cd /Users/yunai/Seata

-

-# 下载

-$ wget https://github.com/seata/seata/releases/download/v1.1.0/seata-server-1.1.0.tar.gz

-

-# 解压

-$ tar -zxvf seata-server-1.1.0.tar.gz

-

-# 查看目录

-$ cd seata

-$ ls -ls

-24 -rw-r--r-- 1 yunai staff 11365 May 13 2019 LICENSE

- 0 drwxr-xr-x 4 yunai staff 128 Apr 2 07:46 bin # 执行脚本

- 0 drwxr-xr-x 9 yunai staff 288 Feb 19 23:49 conf # 配置文件

- 0 drwxr-xr-x 138 yunai staff 4416 Apr 2 07:46 lib # seata-*.jar + 依赖库

-```

-

-## 2.2 启动 TC Server

-

-执行 `nohup sh bin/seata-server.sh &` 命令,启动 TC Server 在后台。在 `nohup.out` 文件中,我们看到如下日志,说明启动成功:

-

-```Java

-# 使用 File 存储器

-2020-04-02 08:36:01.302 INFO [main]io.seata.common.loader.EnhancedServiceLoader.loadFile:247 -load TransactionStoreManager[FILE] extension by class[io.seata.server.store.file.FileTransactionStoreManager]

-2020-04-02 08:36:01.302 INFO [main]io.seata.common.loader.EnhancedServiceLoader.loadFile:247 -load SessionManager[FILE] extension by class[io.seata.server.session.file.FileBasedSessionManager]

-# 启动成功

-2020-04-02 08:36:01.597 INFO [main]io.seata.core.rpc.netty.RpcServerBootstrap.start:155 -Server started ...

-```

-* 默认配置下,Seata TC Server 启动在 **8091** 端点。

-

-因为我们使用 file 模式,所以可以看到用于持久化的本地文件 `root.data`。操作命令如下:

-

-```Bash

-$ ls -ls sessionStore/

-total 0

-0 -rw-r--r-- 1 yunai staff 0 Apr 2 08:36 root.data

-```

-

-后续,胖友可以阅读[「4. 接入 Java 应用」](#)小节,开始使用 Seata 实现分布式事务。

-

-# 3. 部署集群 TC Server

-

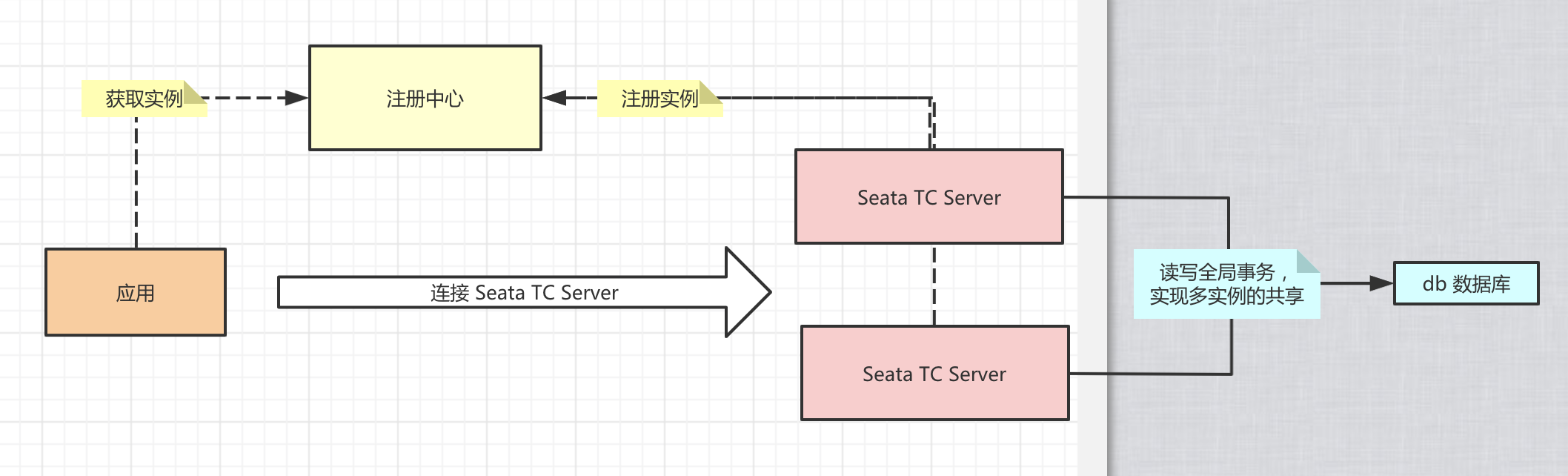

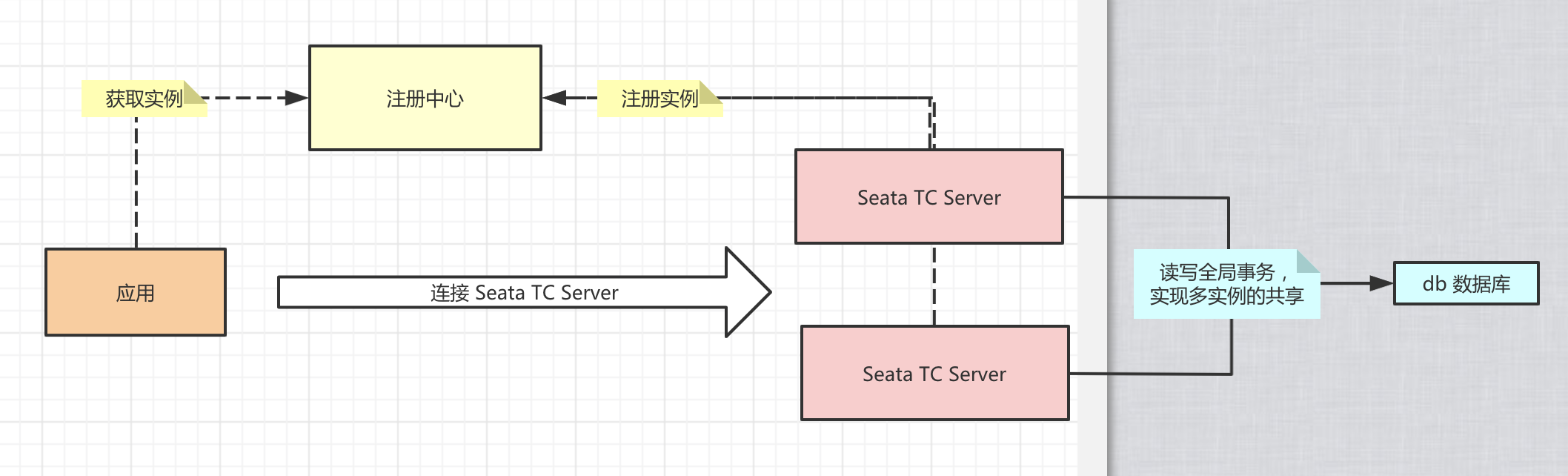

-本小节,我们来学习部署**集群** Seata **TC** Server,实现高可用,生产环境下必备。在集群时,多个 Seata TC Server 通过 **db** 数据库,实现全局事务会话信息的共享。

-

-同时,每个 Seata TC Server 可以注册自己到注册中心上,方便应用从注册中心获得到他们。最终我们部署 集群 TC Server 如下图所示:

-

-Seata TC Server 对主流的注册中心都提供了集成,具体可见 [discovery](https://github.com/seata/seata/tree/develop/discovery) 目录。考虑到国内使用 Nacos 作为注册中心越来越流行,这里我们就采用它。

-

-> 友情提示:如果对 Nacos 不了解的胖友,可以参考[《Nacos 安装部署》](http://www.iocoder.cn/Nacos/install/?self)文章。

-

-哔哔完这么多,我们开始正式部署单机 TC Server,这里艿艿使用 macOS 系统,和 Linux、Windows 是差不多的,胖友脑补翻译。

-

-## 3.1 下载 Seata 软件包

-

-打开 [Seata 下载页面](https://github.com/seata/seata/releases),选择想要的 Seata 版本。这里,我们选择 [v1.1.0](https://github.com/seata/seata/releases/tag/v1.1.0) 最新版本。

-

-```Bash

-# 创建目录

-$ mkdir -p /Users/yunai/Seata

-$ cd /Users/yunai/Seata

-

-# 下载

-$ wget https://github.com/seata/seata/releases/download/v1.1.0/seata-server-1.1.0.tar.gz

-

-# 解压

-$ tar -zxvf seata-server-1.1.0.tar.gz

-

-# 查看目录

-$ cd seata

-$ ls -ls

-24 -rw-r--r-- 1 yunai staff 11365 May 13 2019 LICENSE

- 0 drwxr-xr-x 4 yunai staff 128 Apr 2 07:46 bin # 执行脚本

- 0 drwxr-xr-x 9 yunai staff 288 Feb 19 23:49 conf # 配置文件

- 0 drwxr-xr-x 138 yunai staff 4416 Apr 2 07:46 lib # seata-*.jar + 依赖库

-```

-

-## 3.2 初始化数据库

-

-① 使用 [`mysql.sql`](https://github.com/seata/seata/blob/develop/script/server/db/mysql.sql) 脚本,初始化 Seata TC Server 的 db 数据库。脚本内容如下:

-

-```SQL

--- -------------------------------- The script used when storeMode is 'db' --------------------------------

--- the table to store GlobalSession data

-CREATE TABLE IF NOT EXISTS `global_table`

-(

- `xid` VARCHAR(128) NOT NULL,

- `transaction_id` BIGINT,

- `status` TINYINT NOT NULL,

- `application_id` VARCHAR(32),

- `transaction_service_group` VARCHAR(32),

- `transaction_name` VARCHAR(128),

- `timeout` INT,

- `begin_time` BIGINT,

- `application_data` VARCHAR(2000),

- `gmt_create` DATETIME,

- `gmt_modified` DATETIME,

- PRIMARY KEY (`xid`),

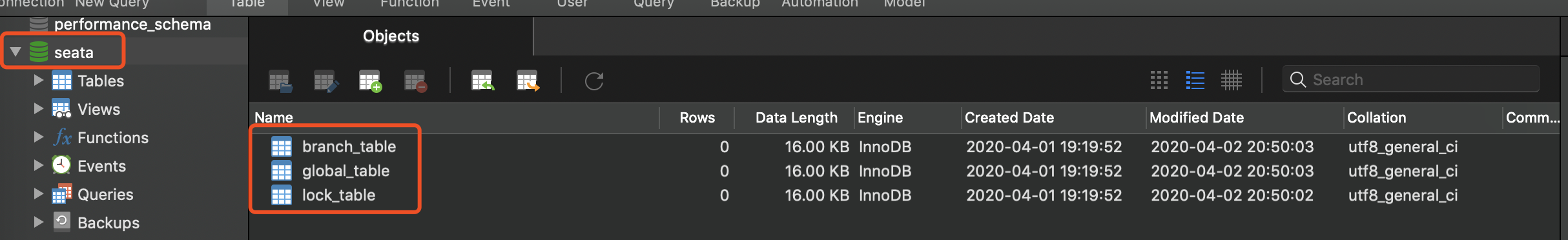

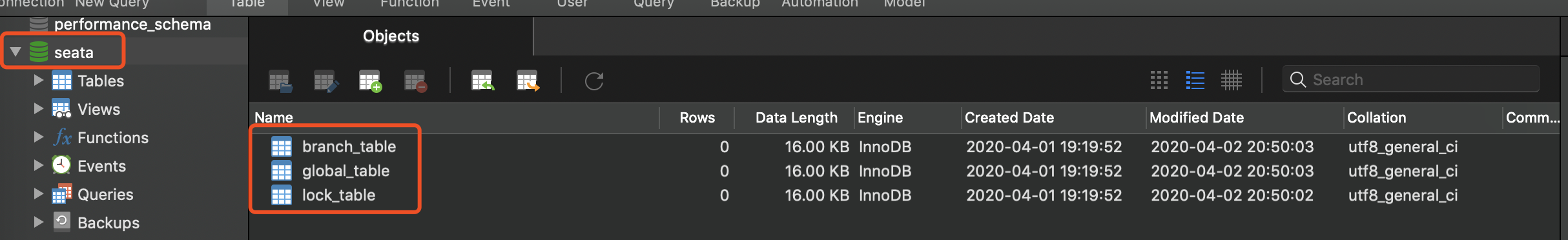

- KEY `idx_gmt_modified_status` (`gmt_modified`, `status`),