diff --git a/2024-09-13-hu/index.html b/2024-09-13-hu/index.html

index 33f704f..d9f2f45 100644

--- a/2024-09-13-hu/index.html

+++ b/2024-09-13-hu/index.html

@@ -42,14 +42,14 @@

13. September 2024

-

+

Dieses Werk ist lizenziert unter einer Creative Commons Namensnennung – Weitergabe unter gleichen Bedingungen 4.0 International Lizenz.

-

+

-

+

---

@@ -60,7 +60,7 @@

-Quelle: [XKCD, Randall Munroe](https://xkcd.com/435) / CC BY-NC 2.5

+Bildquelle: [XKCD, Randall Munroe](https://xkcd.com/435) / CC BY-NC 2.5

--

@@ -107,7 +107,7 @@

-

+

--

@@ -120,15 +120,15 @@

--

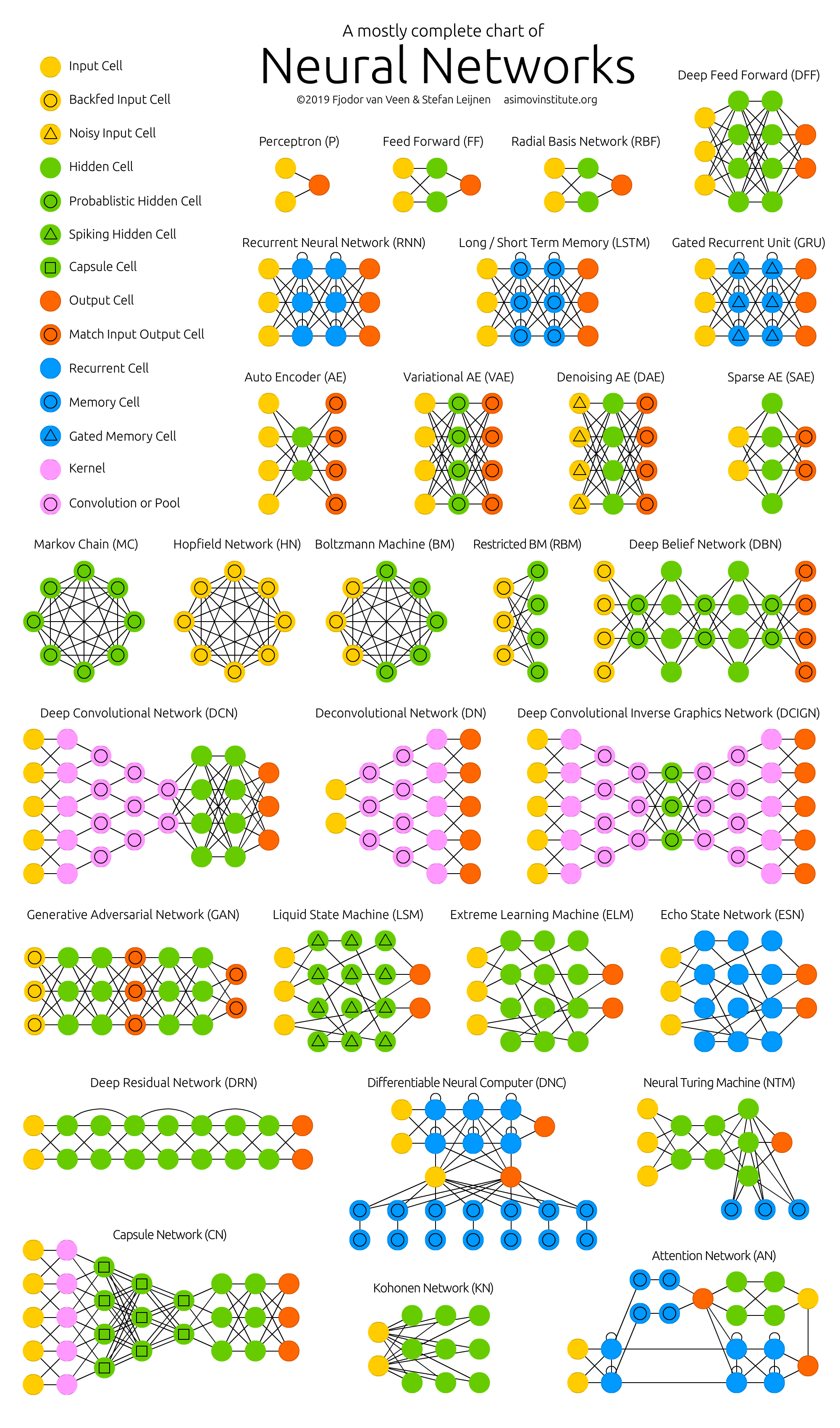

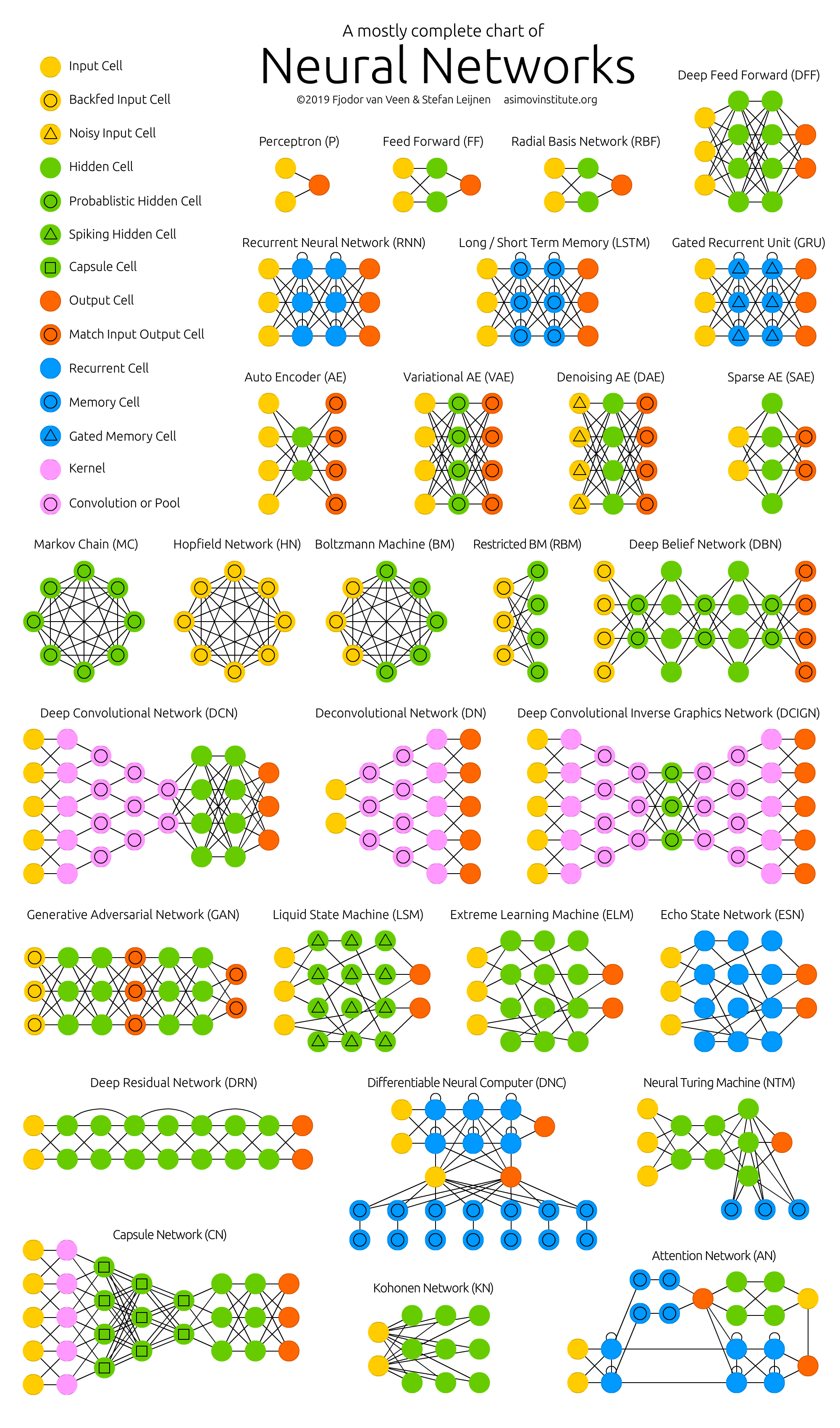

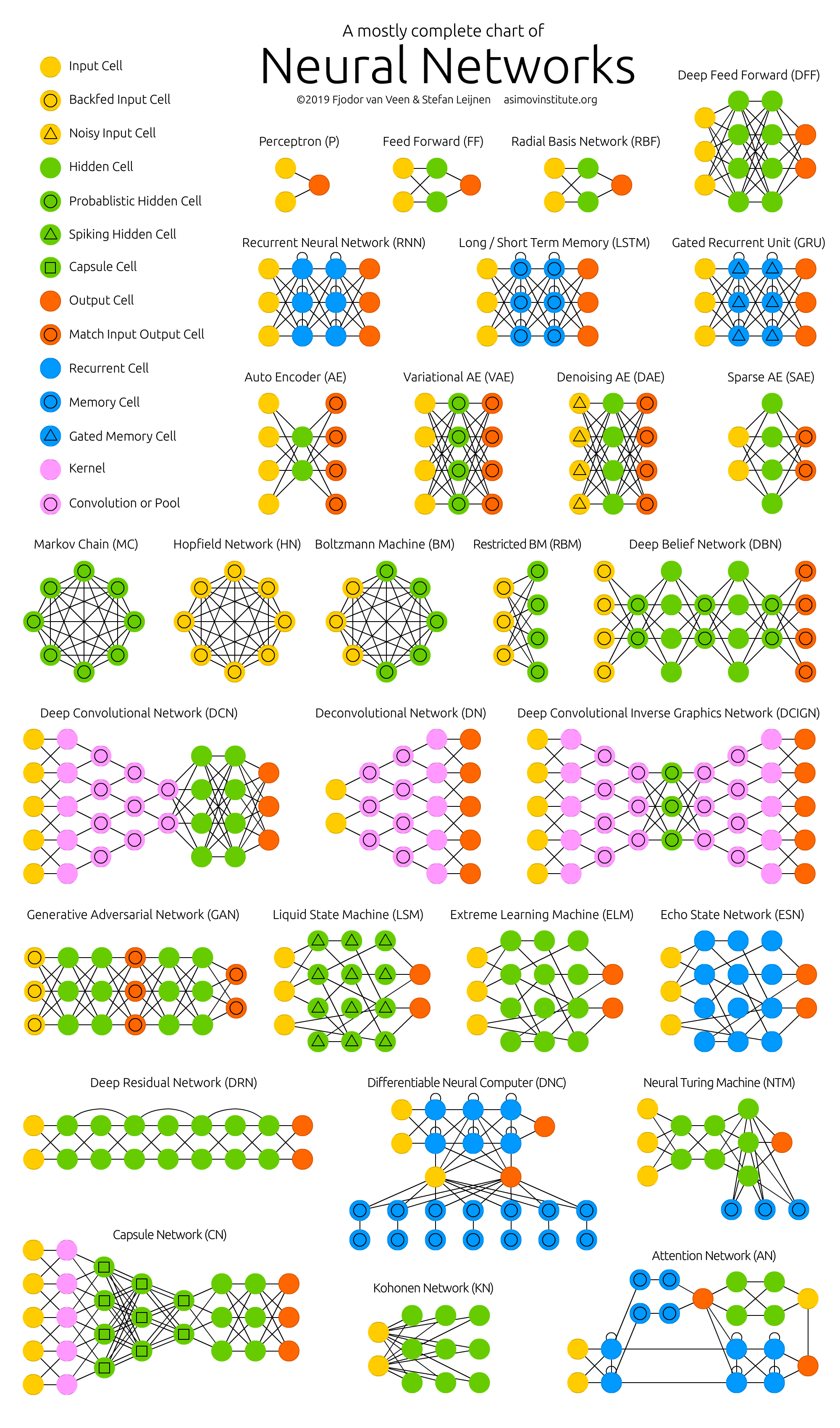

-## Architekturen für neuronale Netze (1/2)

+## Architekturen für künstliche neuronale Netze

-Quelle: [Fjodor van Veen & Stefan Leijnen](https://www.asimovinstitute.org/neural-network-zoo/)

+Bildquelle: [Fjodor van Veen & Stefan Leijnen](https://www.asimovinstitute.org/neural-network-zoo/)

--

-## Architekturen für neuronale Netze (1/2)

+## Architekturen für künstliche neuronale Netze

@@ -136,21 +136,25 @@

## Anwendungsbeispiele

-

+

-

+

-

-T. Weyand, I. Kostrikov, J. Philbin (2016) PlaNet – Photo Geolocation with Convolutional Neural Networks. [doi:10.1007/978-3-319-46484-8_3](https://doi.org/10.1007/978-3-319-46484-8_3)

+

+

+Bildquelle: T. Weyand, I. Kostrikov, J. Philbin (2016) PlaNet – Photo Geolocation with Convolutional Neural Networks. [doi:10.1007/978-3-319-46484-8_3](https://doi.org/10.1007/978-3-319-46484-8_3)

+

-

+

-

-F. Liu, D. Tuo, Y. Xu, X. Han (2023) CoverHunter: Cover Song Identification with Refined Attention and Alignments. [doi:10.1109/ICME55011.2023.00189](https://doi.org/10.1109/ICME55011.2023.00189)

+

+

+Bildquelle: F. Liu, D. Tuo, Y. Xu, X. Han (2023) CoverHunter: Cover Song Identification with Refined Attention and Alignments. [doi:10.1109/ICME55011.2023.00189](https://doi.org/10.1109/ICME55011.2023.00189)

+

-

+

--

@@ -158,12 +162,14 @@

-### Details, die wir auslassen

+### Details, die wir auslassen

- Festlegung Vokabular (Wörter, Silben, etc.)

- Abbildung auf Zahlen

- Architektur des neuronalen Netzes

- ... und noch einiges mehr

+

+

-

+

- ergibt *Pre-Trained (Large) Language Model* → **LLM**

- Extraktion von Vektoren für Wörter ergibt *Word Embeddings*

- semantische Ähnlichkeit durch Nähe im Vektorraum

- Eingabe für neuronale Netze

+

+

--

## Training: Fine-Tuning

@@ -207,7 +215,7 @@

--

-## Beispiele

+## Beispiele für LLMs

@@ -216,12 +224,12 @@

Architektur und Modell

-S. Minaee, T. Mikolov, N. Nikzad, M. Chenaghlu, R. Socher, X. Amatriain, J. Gao (2024) Large Language Models: A Survey. [arXiv:2402.06196v2 ](https://arxiv.org/html/2402.06196v2)

-

-

+

+Bildquelle: S. Minaee, T. Mikolov, N. Nikzad, M. Chenaghlu, R. Socher, X. Amatriain, J. Gao (2024) Large Language Models: A Survey. [arXiv:2402.06196v2 ](https://arxiv.org/html/2402.06196v2)

+

---

+

+

--

## Und jetzt?

@@ -237,7 +247,12 @@

- was ein LLM ist

- wie es trainiert wird

- welche Arten von Aufgaben es gibt

-- welche LLMs es gibt

+- welche Beispiele für LLMs es gibt

+

+

+

+

+→ Was hat es mit dem *Manfred Lehmann unter den rhetorischen Stilmitteln* auf sich?

---

@@ -320,7 +335,7 @@

- wir kürzen ›Vossianische Antonomasie‹ als **Vossanto** ab

-

+

- Source → Modifier → Anzahl der Vossanto-Kandidaten nach jedem Schritt beim regelbasierten Verfahren

-

---

-

## 2. Automatisierte Verfahren

@@ -516,7 +511,7 @@

--

-## Erinnerung: Architekturen für neuronale Netze

+## Erinnerung: Architekturen für künstliche neuronale Netze

@@ -526,22 +521,35 @@

### (B)LSTM ([Hochreiter und Schmidhuber 1997](https://doi.org/10.1162/neco.1997.9.8.1735), [Schuster/Paliwal 1997](https://doi.org/10.1109/78.650093))

+

+

- (Bidirectional) Long Short-Term Memory

- "Erinnerung" vorheriger Werte; Modellierung von Abhängigkeiten zwischen Eingaben

- bidirektional: in beide Richtungen

+

+

### Transformer ([Vaswani et al. 2017](https://proceedings.neurips.cc/paper_files/paper/2017/hash/3f5ee243547dee91fbd053c1c4a845aa-Abstract.html))

+

+

+

- "Nachfolger" von (B)LSTMS

- verarbeiten Eingaben parallel

- integrierte Attention ermöglicht Fokussierung auf bestimmte Eingaben

- Grundlage von BERT und GPT

+

### CRF ([Lafferty et al. 2001]())

+

+

+

- Conditional Random Fields

- **kein** neuronales Netz

- probabilistisches Modell zur Modellierung von Beziehungen

+

+

--

## Verwendete vor-trainierte Modelle